Introduction : Faire avec le numérique ?

Manipuler, ouvrir et lire un livre sont des actes qui engendrent des sensations et des expériences multiples. L’une d’entre elles, probablement la plus inconsciente, concerne la matérialité du livre, qu’il soit imprimé ou numérique : le codex ou l’ebook renferme l’aboutissement de plusieurs dizaines de siècles de recherche et de développement. Ouvrir un livre est donc l’occasion de prendre la mesure de cette prouesse technologique que sont quelques cahiers reliés ou quelques fichiers compressés. Le livre est un moyen d’interroger le rapport que nous entretenons avec la technique, la façon de concevoir et de fabriquer une publication est révélatrice de notre positionnement avec les machines et les programmes. L’informatisation des métiers du livre ainsi que l’arrivée du livre numérique et des nouveaux modes de diffusion de l’écrit modifient la manière d’élaborer des livres ou plus globalement des publications. Conception, fabrication, production, diffusion : l’influence du numérique sur le livre nous amène à devoir nous questionner sur la chaîne de publication et sur ce qui la compose. D’un modèle linéaire nous pouvons envisager un système modulaire, et ainsi remettre en cause des approches basées sur des logiciels. En d’autres termes, comment éditer avec le numérique1 ?

Informatisation des métiers du livre

Les métiers du livre – auteurs, édition, distribution/diffusion, librairie et bibliothèque – connaissent différentes phases d’informatisation depuis les années 1970, portées par un marché économique en transformation (Longhi & Rochhia, 2014). Que ce soit les systèmes d’information des bibliothèques, puis les logiciels de traitement de texte et de publication assistée par ordinateur des auteurs et des éditeurs, et les infrastructures de diffusion de l’information pour la distribution/diffusion et la librairie, les activités des métiers du livre ont été bouleversées avec la même force que l’arrivée de l’imprimerie à caractères mobiles. Les bibliothèques ont été pionnières avec la mise en place de catalogues permettant de gérer le classement et l’organisation des collections ; les maisons d’édition, quant à elles, ont commencé à utiliser des ordinateurs et des logiciels à partir du début des années 1980. Les premiers traitements de texte et logiciels de publication assistée par ordinateur ont créé de nouvelles possibilités pour les éditeurs et les auteurs : temps de conception réduit, facilité de modification des maquettes, prévisualisation des compositions et mutualisation des efforts avec des schémas reproductibles. Aujourd’hui deux logiciels semblent disposer d’une position hégémonique : le traitement de texte Microsoft Word et le logiciel de publication assistée par ordinateur Adobe InDesign sont les deux outils professionnels les plus répandus dans le domaine de la publication, qu’il s’agisse d’imprimé ou de numérique. Leurs fonctionnalités correspondent à des besoins identifiés à travers le prisme de l’objet imprimé, le livre numérique numérique est l’occasion de réviser le paradigme imposé par ces logiciels.

Essor du livre numérique

Le livre numérique est une vieille histoire : le premier specimen a été créé en 1971 par Michael Hart dans un objectif de diffusion d’un texte majeur via les premiers réseaux informatiques (Lebert, 2016, chap. 1). La version numérique de The Declaration of Independence of the United States of America par Thomas Jefferson, au format texte et sans mise en forme, est également le point de départ du projet Gutenberg (http://www.gutenberg.org/ebooks/1). Ce n’est qu’à la moitié des années 2000 que le livre numérique est popularisé : avec la standardisation du format EPUB en 2015, la disponibilité d’un support de lecture à encre électronique bon marché – aussi appelé liseuse – en 2016, et enfin avec la commercialisation d’un catalogue numérique également en 2016.

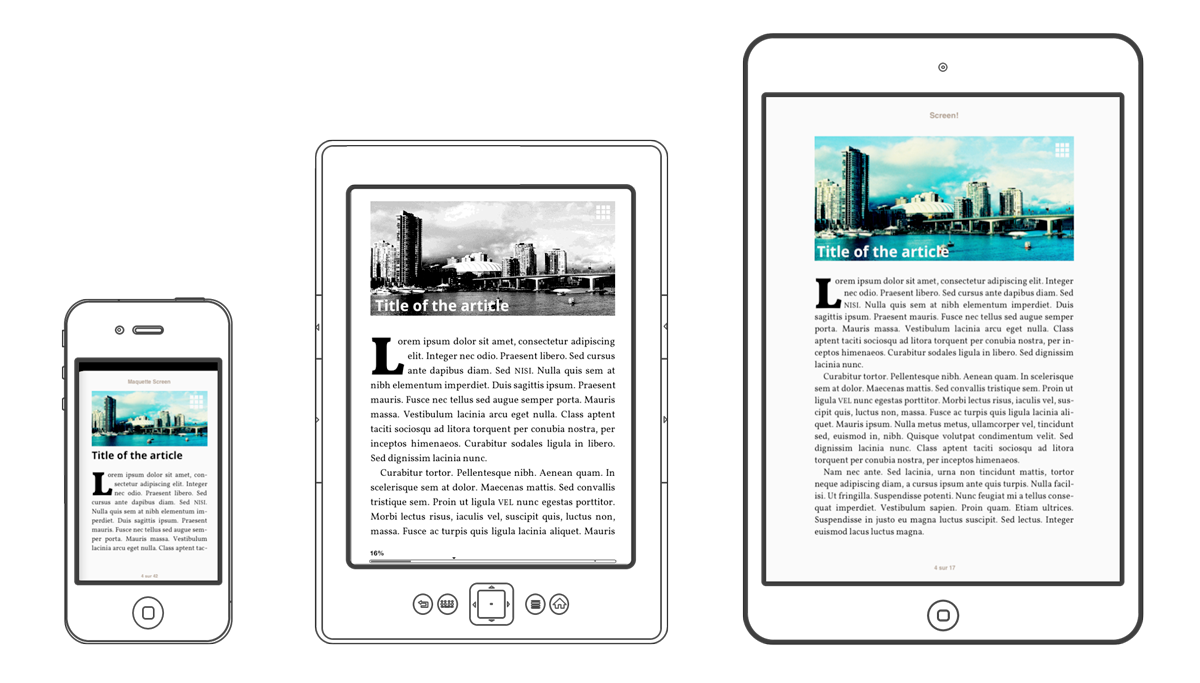

Le livre numérique reste majoritairement homothétique – les enrichissements sont rares (Benhamou, 2014, p. 148) –, et il est souvent produit par un sous-traitant après la version imprimée, générant potentiellement une dette technique (Faucilhon, 2016). Si l’ebook représente une nouvelle économie fragile – la part des ventes numériques dans le chiffre d’affaires des éditeurs peine à atteindre les 10% (« Les chiffres du numérique », 2018) –, il ébranle toutefois les principes de l’édition. Le contenu liquide peut être reformaté par le lecteur, remettant en cause les choix typographiques de l’éditeur, comme le souligne Philippe Millot :

Avec le texte au format numérique, à la mise en page liquide, chacun peut changer les paramètres élémentaires. Il faudrait être typographe soi-même pour lire son livre savamment et ne pas jeter plus de mille ans de connaissance de mise en forme du texte.

(Renou-Nativel, 2012)

Aussi, la dimension de flux concerne autant le livre que sa diffusion sur Internet sur des plates-formes diverses, et la fabrication des EPUB repose sur des technologies empruntées au Web – notamment les langages HTML et CSS (Vitali Rosati & Eberle-Sinatra, 2014). Au-delà des nouvelles possibilités de diffusion il y a en creux des changements plus profonds, comme la manière de concevoir un livre : le texte n’est plus forcément composé page à page, mais doit être considéré comme un flux (Tangaro, 2017) dont certains comportements peuvent être anticipés. Par ailleurs l’utilisation de formats ouverts et de standards qu’implique l’EPUB invite ceux qui fabriquent les livres à envisager de nouvelles façons de faire et ainsi à modifier leur chaîne de publication.

Chaîne de publication

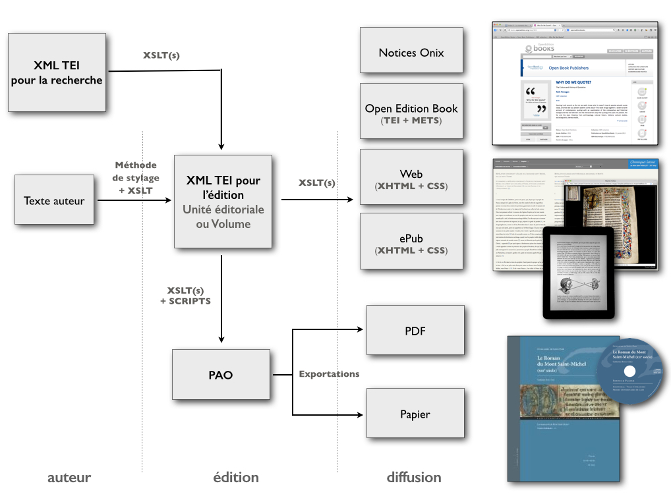

Par chaîne de publication nous entendons l’ensemble des méthodes et des outils permettant de concevoir, fabriquer, produire et diffuser un livre ou une publication. Une chaîne de publication réunit des logiciels propres à la gestion du texte et des images, mais aussi les différents rôles d’un processus éditorial que sont l’auteur, l’éditeur, le correcteur, le graphiste ou l’imprimeur. Une chaîne de publication, également appelée chaîne d’édition ou chaîne éditoriale (Arribe, 2014, p. 206), a pour objectif de gérer des contenus depuis le manuscrit d’un auteur jusqu’à la publication imprimée ou numérique d’un ouvrage, en passant par les phases de structuration, de relecture et de mise en forme. Cette chaîne, ce workflow, est le noyau d’une maison d’édition pour manier des textes et leur donner vie sous forme de livre. Classiquement une chaîne de publication comprend un traitement de texte et un logiciel de publication assistée par ordinateur, certains domaines éditoriaux comme l’édition scientifique ont des outils pour structurer plus finement le contenu et pour générer des formats spécifiques. Identifier les éléments d’une chaîne d’édition est une étape nécessaire pour pouvoir la reconsidérer et ainsi formuler un nouveau modèle.

Interroger la façon de produire des livres

L’informatisation des métiers du livre et le développement du livre numérique sont deux phénomènes qui conduisent à repenser la manière de fabriquer des publications : il ne s’agit plus seulement de réaliser des ouvrages imprimés avec des logiciels et de créer des équivalents dématérialisés, mais de prendre en compte la dimension numérique dès la conception et la fabrication, et jusque dans les formes proposées. Si les outils utilisés dans l’édition sont vus comme de simples exécutants de tâches précises et complexes, l’ebook a introduit une nouvelle dimension, invitant celui ou celle qui compose le livre à entrer au cœur du contenu, et à concevoir de nouvelles formes.

Si l’informatique a longtemps été considérée comme au service d’un objet imprimé, comment, aujourd’hui, éditer avec le numérique ?

Si le modèle linéaire et relativement figé des chaînes d’édition classiques est pertinent pour la conception et la production d’ouvrages imprimés, ne faut-il pas le revisiter pour des publications numériques en s’inspirant des méthodes et des technologies utilisées dans le développement web ?

L’un des objectifs de cette conceptualisation d’un projet non conventionnel est de donner une plus grande maîtrise à celles et ceux qui produisent des textes et des publications : auteurs et éditeurs en premier lieu, notamment dans le domaine de l’édition savante (Vitali-Rosati, 2016), mais plus globalement pour les ouvrages dits de non-fiction comme les essais ou les manuels. Et il y a urgence.

Avec le numérique

Afin d’appréhender un nouveau modèle de fabrication des livres ou des publications, ce mémoire s’articule autour de trois grandes parties qui constituent également une méthodologie à trois pans : l’analyse de trois textes, l’analyse de trois initiatives originales et la formalisation d’une proposition inédite.

Avant de découvrir des cas dans lesquels le numérique prend une place prépondérante pour réaliser des publications, nous devons exposer les hybridations de l’imprimé et du numérique, critiquer un usage solutionniste de la technologie et présenter un nouveau rapport à la technique. Cette première partie constitue le premier volet de notre méthodologie, et entend nourrir les propositions de la troisième partie. L’ouvrage d’Alessandro Ludovico, Post-Digital Print : la mutation de l’édition depuis 1894, explore les nombreux exemples en œuvre depuis la fin du dix-neuvième siècle en matière d’édition hybride. Pour tout résoudre, cliquez ici : l’aberration du solutionnisme technologique d’Evgeny Morozov met à mal les recours parfois hâtifs de la technologie pour améliorer le monde. Enfin, la thèse de Gilbert Simondon publiée en 1958, Du mode d’existence des objets techniques, ouvre une nouvelle perspective quant au positionnement de l’homme par rapport aux machines – et par extension, aux programmes informatiques.

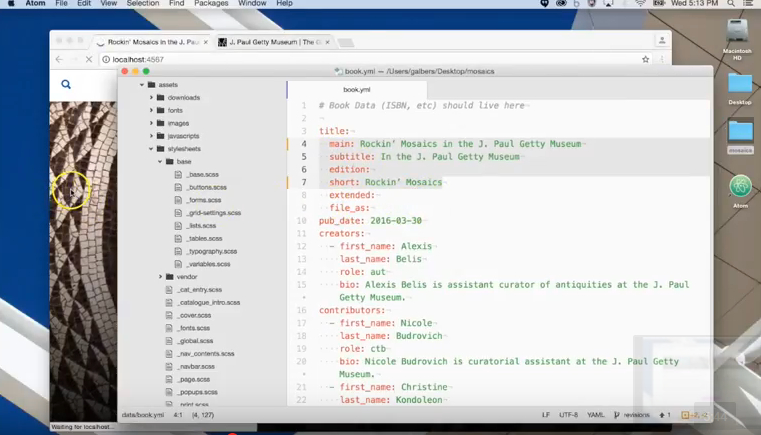

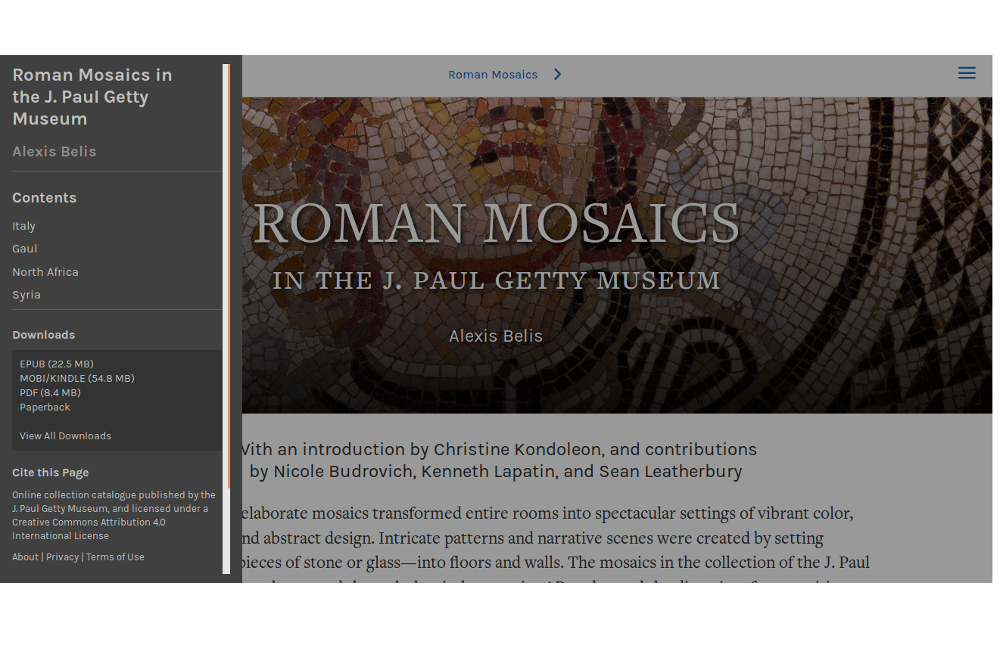

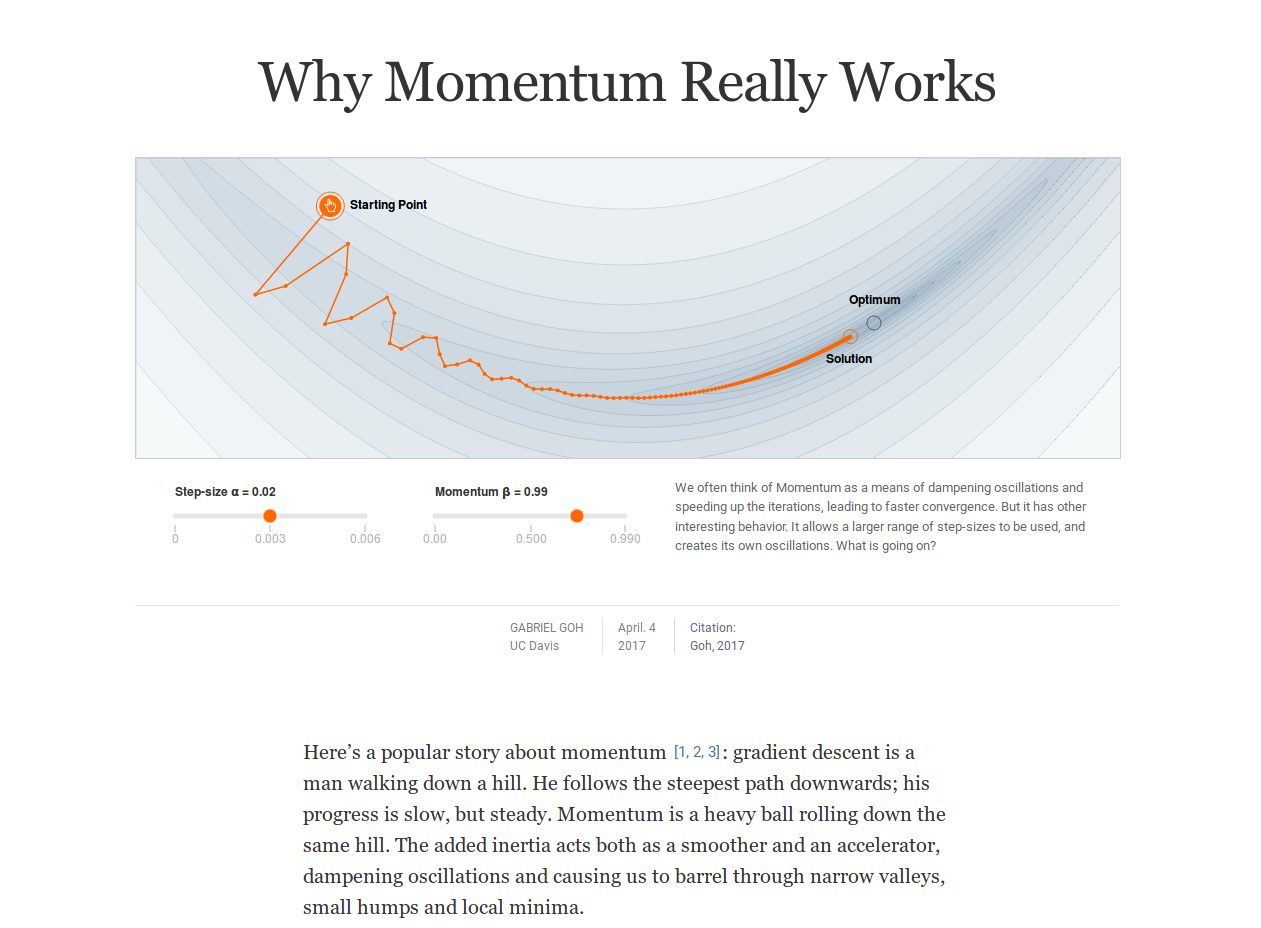

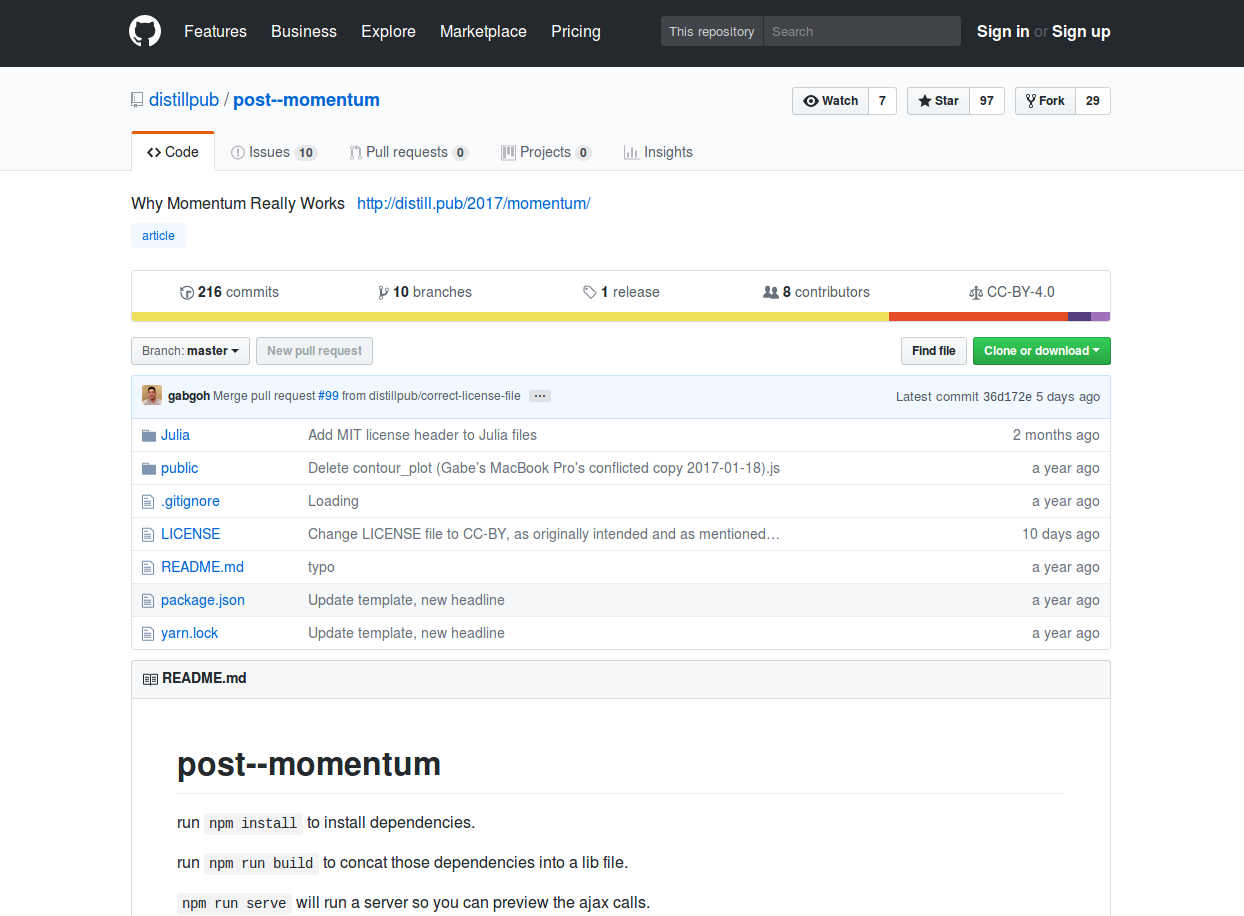

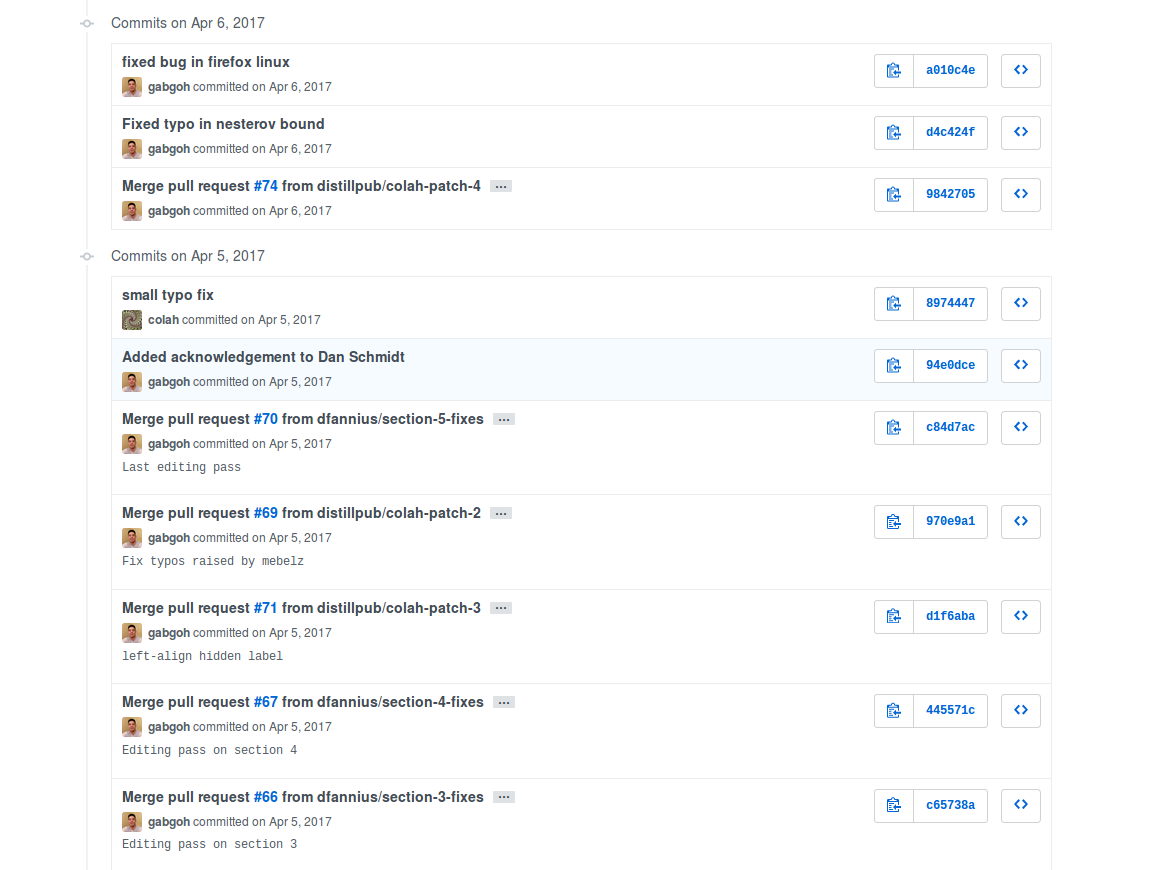

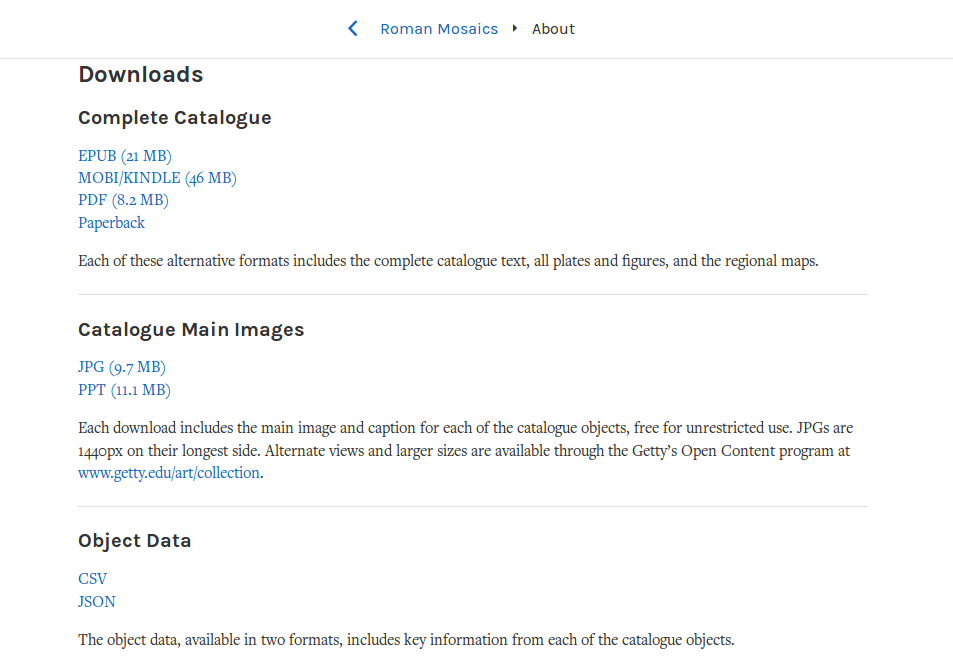

Le numérique est bien souvent une version supplémentaire venant s’ajouter au traditionnel ouvrage papier, plutôt qu’une nouvelle dimension autant pour l’accès au texte que pour sa production. Certaines structures d’édition ont fait évoluer leur chaîne pour prendre en compte d’abord la version numérique, se passant du même coup de logiciels dits classiques pour l’élaboration d’ouvrages imprimés. Cette seconde partie, également second versant de notre méthodologie, est un outil indispensable pour parvenir à extraire les éléments d’un nouvel archétype. Nous analysons les approches de trois structures d’édition pour exposer et comprendre leur fonctionnement : les différents outils développés par l’éditeur O’Reilly Media, la chaîne de publication nativement numérique Quire de Getty Publications, et la revue académique Distill.

Dans un troisième temps, et à partir des textes étudiés et des cas analysés, nous esquissons les principes d’un modèle alternatif : un système modulaire de publication. Nous décortiquons tout d’abord les différentes étapes qui composent une chaîne d’édition : écriture, structuration, validation, mise en forme et génération des formats. Nous exposons ensuite trois principes à partir desquels un système modulaire de publication peut être mis en place : interopérabilité, modularité et multiformité. En filigrane et à partir des analyses de texte, nous interrogeons notre rapport à la technique.

La technique est un bien social à investir d’urgence et à tout prix. […]

Qu’elle soit un langage, un objet ou un milieu, la technique est un bien social parce qu’elle est l’une des composantes indispensables à l’existence et à l’évolution des liens sociaux.

(Gelgon, 2018)

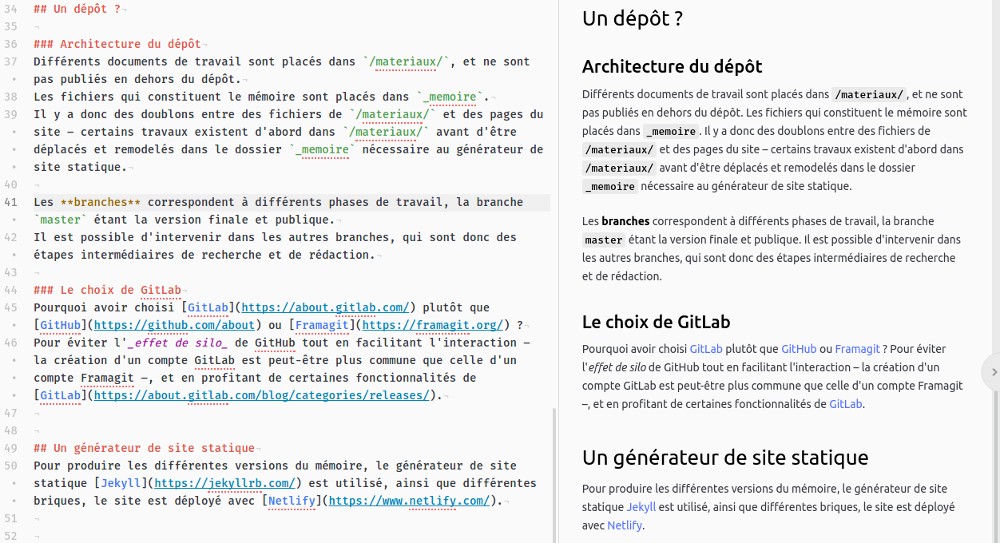

Un mémoire modulaire

La construction de ce mémoire est progressive et originale : à la suite d’un article introductif publié en 2017 (Fauchié, 2017), les différentes parties ont été rédigées afin de pouvoir être lues indépendamment. Les commentaires de texte et les analyses de cas, traditionnellement placés en annexe, font partie intégrante du mémoire. Celui-ci est un agencement de textes autonomes suivant un fil rouge commun, plusieurs sens de lecture sont possibles.

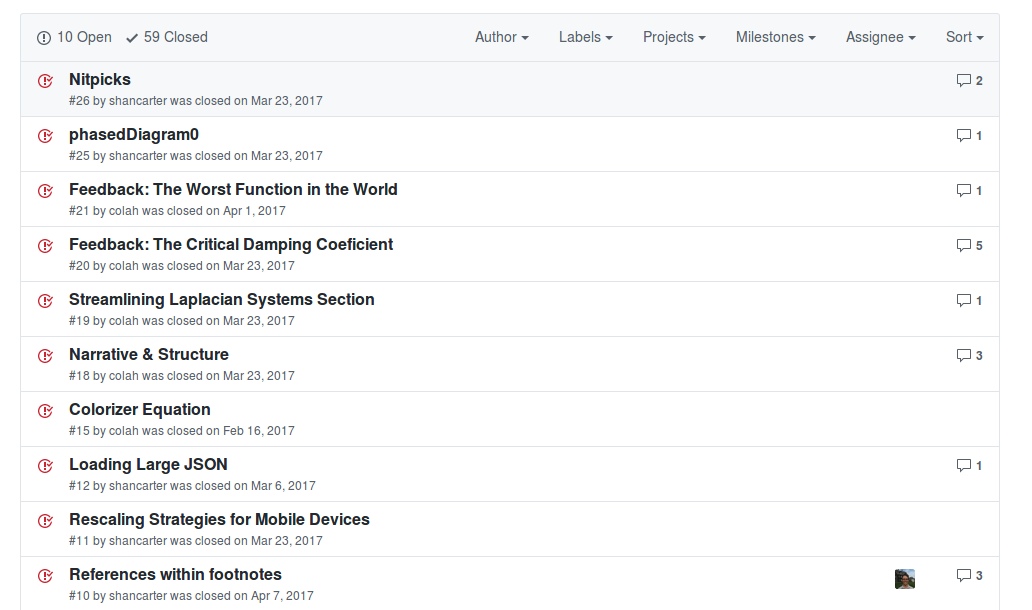

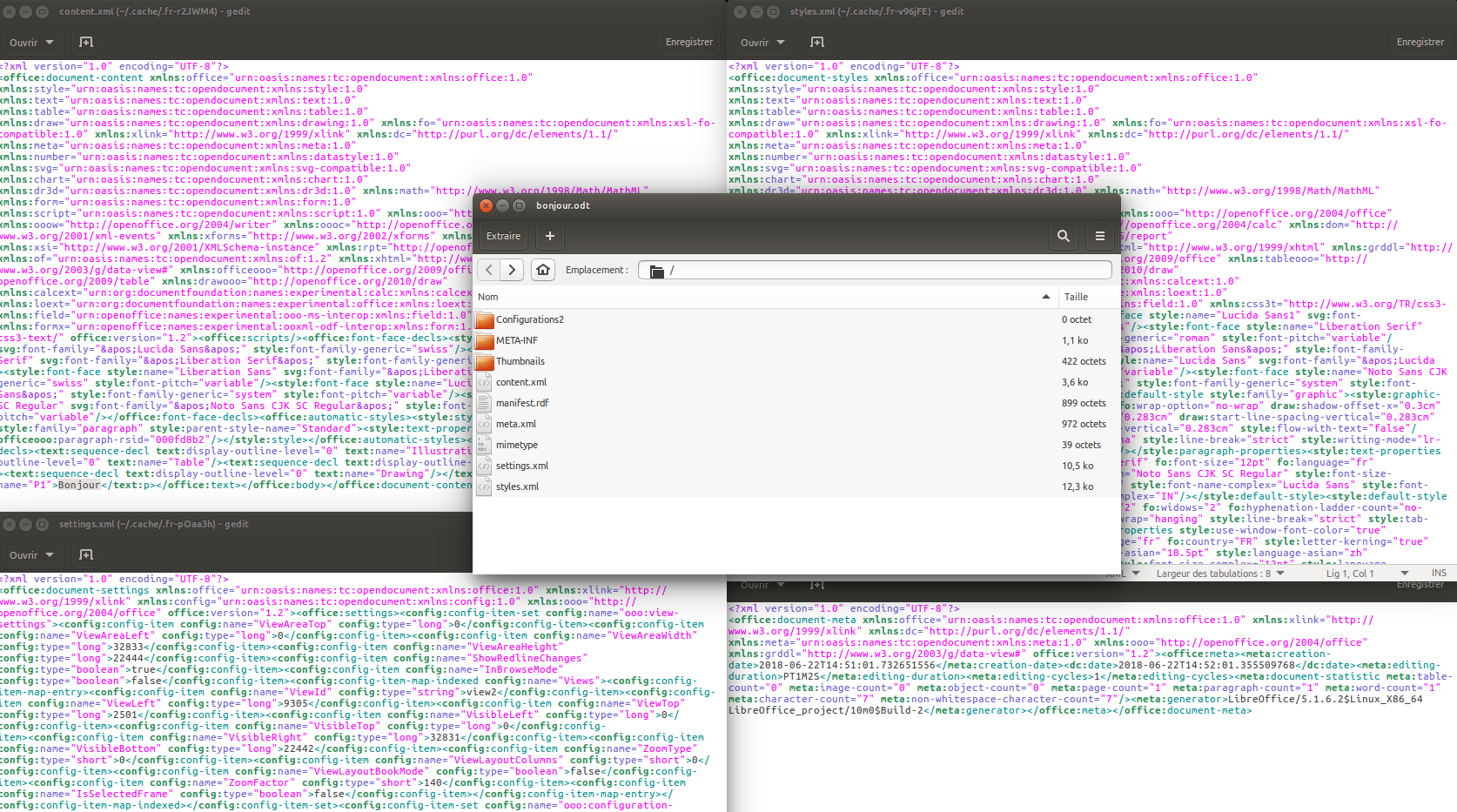

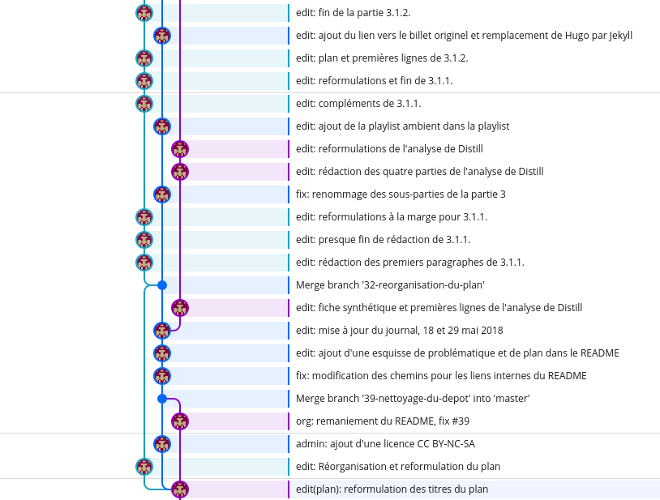

Ce mémoire est l’occasion d’appliquer, pour cette modeste publication, les principes exposés ici : l’interopérabilité, la modularité et la multiformité. Les sources sont dans un format interopérable et sont versionnées, permettant d’envisager différents traitements du texte, mais aussi pour faciliter les éventuelles interventions extérieures2. Ce texte est disponible en version numérique, et plus particulièrement sous la forme d’un site web, mais également en version imprimée3.

Enfin, un certain nombre de travaux ont été réalisés en parallèle de ce mémoire – articles, communications lors de colloques et collaborations diverses : ces initiatives satellites permettent de structurer et d’alimenter un travail de recherche qui a débuté en mars 2017, ouvrant également des opportunités de collaboration avec des personnes qui produisent des publications avec le numérique4.

La lecture de Vers un système modulaire de publication : éditer avec le numérique est plurielle : elle peut débuter par la partie 3 pour ensuite revenir aux parties 2 et 1, tout comme elle peut être linéaire en suivant l’ordre du plan. Si les processus, quels qu’ils soient, doivent toujours être interrogés, il en va de même de ce mémoire qui est une incitation à reconsidérer les modes de fabrication du livre plutôt qu’une proposition à appliquer. Enfin, cet exercice de recherche est une tentative de publier avec le numérique.

1. Mutations du livre

Ce mémoire fait référence à nombre d’ouvrages et d’articles scientifiques5, ainsi qu’à d’autres textes permettant de donner un socle théorique à ce travail de recherche. Avant d’étudier des projets et d’explorer certaines pistes, nous avons jugé nécessaire de prolonger cet exercice bibliographique par l’analyse de trois livres, et d’intégrer ces commentaires de texte dans le mémoire. Des transformations de l’édition au « progrès technique » en passant par le « solutionnisme technologique », ces trois analyses sont autant d’occasions d’interroger les mutations du livre avec un esprit critique et des approches originales. Nous prenons le temps de présenter, résumer et disséquer trois textes, puis de proposer une courte hypothèse pour chacun d’eux : comment interroger la question des chaînes de publication avec les approches de chacun de ces auteurs ?

Post-digital print: la mutation de l’édition depuis 1894 (Ludovico & Cramer, 2016) est un ouvrage incontournable pour qui s’intéresse aux évolutions du livre et de la presse au vingtième et au début du vingt-et-unième siècle. Alessandro Ludovico y expose le concept d’« hybridation » à propos de la rencontre et de l’articulation entre papier et numérique, tentant de ne pas opposer ces deux mediums. Post-Digital Print est aussi un moyen d’aborder la question des formes du livre, multiples avant puis avec le numérique. L’hybridation n’est-elle réalisable qu’à condition de repenser les chaînes de publication ?

Pour tout résoudre, cliquez ici: l’aberration du solutionnisme technologique (Morozov, 2014) porte une voix dissidente par rapport aux enthousiastes – pour ne pas dire fanatiques – du numérique. Evgeny Morozov analyse de nombreux exemples où la technologie est mal employée, utilisée comme une solution en soi sans prendre en compte les problèmes qu’elle est censée résoudre. Comme Gilbert Simondon dont un des ouvrages majeurs est étudié dans un troisième temps de cette première partie, Evgeny Morozov défend l’idée que l’enjeu actuel n’est pas d’adhérer aveuglement ou de rejeter totalement la technologie, mais d’envisager une utilisation plus réfléchie. Les travers présentés dans Pour tout résoudre, cliquez ici peuvent être similaires dans le domaine de l’édition : l’usage systématique de logiciels monolithiques n’est-il pas problématique ?

Du mode d’existence des objets techniques (Simondon, 2012) est un texte fondateur dans le champ de la philosophie de la technique qui a influencé nombre de penseurs et d’auteurs. Gilbert Simondon y développe une thèse critiquant une vision dichotomique de la technique, cette dernière étant soit envisagée comme uniquement utilitariste, soit sacralisée ou rejetée. Il s’agit de repenser notre positionnement par rapport à la « machine », que la civilisation comprend mal. À partir de la thèse de Gilbert Simondon, comment pouvons-nous reconsidérer la place de l’humain par rapport à une chaîne d’édition classique, faite de logiciels hermétiques ?

Comme précisé dans l’introduction, ces commentaires de texte ne sont pas placés en annexes, afin de traduire les principes exposés ici : ce mémoire se veut un ensemble modulaire, dont les analyses de ces trois textes constituent le fondement théorique.

1.1. Hybridation

Les ouvrages abordant l’édition et le numérique sont nombreux, bien souvent concentrés sur des questions économiques et focalisés sur la grande édition. La littérature sur ce sujet oublie parfois que les pratiques les plus enrichissantes proviennent d’initiatives alternatives voir expérimentales. Dans ce paysage éditorial Post-Digital Print : la mutation de l’édition depuis 1894 (Ludovico & Cramer, 2016) est un sursaut bienvenu doublé d’un travail de recherche remarquable : cet essai est constitué d’une présentation historique et d’une analyse fine de l’évolution de l’imprimé au contact du numérique. Cette traduction française du livre d’Alessandro Ludovico publiée par les éditions B42 est d’un apport majeur.

Alessandro Ludovico est un chercheur, un enseignant, un artiste et un éditeur dont les intérêts et les écrits sont tournés vers le numérique et l’édition alternative depuis plus de vingt ans. Il est le créateur et rédacteur en chef de la revue Neural – fondée en 1993 et consacrée aux arts numériques.

Post-Digital Print : la mutation de l’édition depuis 1894 est publié en anglais en 2012, suite à un travail de recherche mené à la Hogeschool de Rotterdam, et disponible sous différents formats : un fichier PDF pour une diffusion numérique, une version imprimée à la fois en offset et en impression à la demande pour une distribution physique. Cette multi-disponibilité reflète ce qu’Alessandro Ludovico expose dans son livre : le papier et le numérique sont désormais complémentaires après plus d’un siècle de cohabitation, de rencontre et parfois de fusion. Post-Digital Print est réédité en 2014 par Onomatopee, puis publié par les éditions B42 en 2016 avec une traduction française de Marie-Mathilde Bortolotti.

Nous nous concentrons ici sur l’ensemble de l’ouvrage en tant que panorama et perspective de la publication en lien avec le numérique. Nous souhaitons également analyser l’évolution des chaînes de publication comme un des éléments de cette transformation de l’édition esquissée par Alessandro Ludovico.

1.1.1. Une rétrospective et une prospective de l’édition

Post-Digital Print est divisé en six parties, formant à la fois un parcours historique de l’édition et une analyse précise de projets éditoriaux et alternatifs depuis 1894. Pourquoi 1894 ? Il s’agit de l’année de publication d’un ouvrage qui imagine l’édition comme intégrant la voix sous forme directe (via le téléphone) et enregistrée (sur cylindre) : La Fin des livres d’Octave Uzanne et Albert Robida. Le premier chapitre de Post-Digital Print est consacré à l’analyse de la supposée « mort du papier » (p. 15) à partir de sept cas illustrant les propos d’Alessandro Ludovico. Le second chapitre examine l’édition alternative au vingtième siècle, principalement sur la période 1950-1980 qui a vu naître nombre d’initiatives éditoriales liées aux évolutions technologiques, en parallèle d’une édition classique. Le chapitre trois étudie la transformation du papier avec les bouleversements induits par le numérique, l’impression à la demande en est un exemple emblématique. Le quatrième chapitre explore les expérimentations, projets et entreprises d’édition numérique : que ce soit des plates-formes de vente en ligne, la distribution, les bibliothèques, mais également les artistes. Le chapitre cinq aborde la question de l’archivage, essentielle dans la problématique du papier en lien avec le numérique : de l’interrogation du support à celle de la constitution d’archives, en passant par la diffusion et la visibilité de celles-ci, passées ou futures. Le sixième et dernier chapitre s’attarde sur la question du réseau : en quoi transforme-t-il l’édition ? Et n’est-il pas le moyen pour celle-ci de dépasser la combinaison papier-numérique et de tendre vers une hybridation ?

Prenons le temps d’entrer dans ces différents chapitres pour comprendre l’intérêt de cette approche historique et l’analyse de ces nombreux cas d’édition alternative.

1.1.2. Les six chapitres de Post-Digital Print

Le premier chapitre est consacré à une histoire des media, depuis le télégraphe jusqu’à Internet, à travers laquelle Alessandro Ludovico analyse leurs relations et impacts avec les formats du livre et de la presse. Différentes inventions – conceptualisées, expérimentées ou adoptées – ont permis au texte imprimé d’évoluer, sans pour autant remettre en cause son existence, même si les prédicateurs de la fin du livre furent nombreux. L’hypertexte, Internet et la mise en réseau des acteurs du texte sont peut-être les seuls bouleversements en mesure de nous faire envisager une modification profonde de l’imprimé, malgré des limites d’usage.

Dans le second chapitre Alessandro Ludovico explore les évolutions des techniques d’impression en présentant différentes initiatives de publication de mouvements avant-gardistes – activistes, politiques ou artistiques. Du miméographe à la photocopie en passant par l’offset, des courants comme le futurisme italien, le dadaïsme ou le fanzine punk ont su s’approprier les technologies de reproduction, et qui plus est expérimenter des formes graphiques inédites. L’édition alternative a été un véritable laboratoire de l’impression, jusqu’au multimédia – représenté par le CD-ROM – et au numérique – dont Internet est la figure emblématique.

Les journaux et les magazines ont été les « objets imprimés » (p. 78) qui ont le plus vivement ressenti les mutations de l’édition avec le numérique : c’est l’objet du chapitre 3. Avec l’influence du web et de ses usages, l’« unité atomique » (p. 67) est passée du journal à l’article, remettant en cause le rôle de l’éditeur via des possibilités de personnalisation des contenus. L’impression à la demande, sorte de photocopieuse du début du vingt-et-unième siècle, est la matérialisation des processus en œuvre dans l’édition en ligne, notamment avec la facilité et la rapidité de production et de diffusion. Si d’un côté les magazines recherchent de nouveaux moyens pour résister – via des démarches développant leur visibilité ou par la réintroduction du « geste éditorial » (p. 75) –, l’« automatisation totale » (p. 91) de la publication est désormais accessible, et est le signe sinon la preuve d’un « mariage » entre l’impression et le numérique.

Le quatrième chapitre débute sur un constat : le livre numérique est né d’une intention de partage, intention qui a pu se transformer en une nouvelle forme de lecture grâce à un dispositif de lecture numérique intuitif et convivial, la liseuse à encre électronique. Cette nouvelle perspective, permise aussi par des sociétés qui usent de renforts marketing très puissants et dont les intentions sont clairement mercantiles, implique des enjeux de design : forme du texte, interface de lecture, reproduction de l’espace du livre, etc. Le « reformatage » (p. 110) du texte, comme l’appelle Alessandro Ludovico, est une condition du développement et du déploiement de ces nouveaux usages, offerte par le format EPUB. Comme nous pouvions le prévoir le développement du livre numérique va engendrer une modification de la figure du livre imprimé, ce dernier devenant un objet « rare » et « précieux » (p. 121) via l’utilisation d’éléments difficilement reproduisibles mécaniquement. Le numérique est alors un outil de diffusion des productions imprimées. Alessandro Ludovico rappelle, à juste titre, que la dématérialisation a un coût écologique – malgré le discours visant au sans papier –, et que les interfaces numériques ne proposent pas encore un confort de lecture similaire aux objets imprimés. La dualité entre imprimé et numérique est largement exposée dans Post-Digital Print, l’objet du chapitre suivant est justement de dépasser cette dualité.

De la même façon que le livre numérique a été une opportunité commerciale, la numérisation rétrospective de l’imprimé portée par des sociétés privées représente une manne financière immense, il ne s’agit donc pas que d’une entreprise patrimoniale : voici comment s’ouvre le cinquième chapitre. Entre le placement de publicités sur une masse de contenus considérable, et le phénomène d’attraction pour les ouvrages sous droits, peu d’initiatives permettent de concurrencer Google Books, et de proposer des archives réellement ouvertes aux cultures et disponibles librement pour tous. En dehors de ces projets d’archivage certaines initiatives de numérisation consistent à créer des versions plus exploitables que le papier, avec les techniques de reconnaissance de caractères ou le format PDF. Pour Alessandro Ludovico le défaut des « petits éditeurs » est d’avoir considéré le web comme un vecteur commercial, et non comme l’occasion de repenser une diffusion culturelle ou une nouvelle démarche de visibilité de leurs activités, deux options bien plus riches justement permises par un dépassement de la simple numérisation. Ce cinquième chapitre se clôt sur le concept de scrapbooking qui, à l’ère numérique, est la possibilité de constituer des archives éditorialisées et pérennes. Un élément clé permet d’envisager cela : le réseau.

Les premières lignes du sixième et dernier chapitre sont un rappel : en dehors de la littérature les livres sont des objets conceptuellement connectés entre eux, par exemple via des citations ou des bibliographies. Ainsi l’hypertexte ne fait que faciliter la profusion des liens et augmenter la dimension d’un réseau déjà constitué. Le numérique renforce cette nécessité d’une mise en réseau entre éditeurs, nœuds d’une structure distribuée. La distribution est justement une question centrale dans une activité de publication, « Et si Internet nous a appris quelque chose, c’est bien que la puissance combinée des nœuds individuels (et se renforçant mutuellement) est illimitée » (p. 163). Internet est plus qu’un nouveau canal de diffusion – comme l’ont été le télégraphe, la radio ou la télévision –, c’est aussi une « infrastructure » (p. 173) et un moyen d’imaginer de nouvelles modalités de distribution.

1.1.3. Vers une hybridation

Dans la conclusion de son ouvrage Alessandro Ludovico revient sur l’évolution des medias, et il note que la situation de l’imprimé est bien distincte de celles de la musique ou de la vidéo : « L’impression, néanmoins, est un cas très différent, puisque le medium – la page imprimée – est plus qu’un simple vecteur de matériel destiné à être montré sur un système d’affichage distinct ; c’est aussi le système d’affichage lui-même. » (p. 175) Ainsi, passer au numérique impose une modification de nos usages et de notre rapport avec le livre. L’hybridation serait le moyen de dépasser ce qui se limite à des nouveaux modes de lecture ou de consommation, pour atteindre un niveau « processuel » : le développement de nouvelles formes artistiques, des incidences sur l’environnement social et politique, etc.

L’« impression postnumérique », concept clé de ce livre, serait donc la combinaison de plusieurs éléments : depuis le modèle de la souscription via Internet jusqu’à l’hybridation de l’imprimé et du numérique en passant par l’utilisation d’un ordinateur pour concevoir et produire les objets imprimés et numériques. Citons quelques exemples utilisés par Alessandro Ludovico. Cory Doctorow propose des formats numériques gratuits (PDF, EPUB ou audio) et imagine plusieurs formes de livres imprimés – du format poche imprimé à la demande via la plate-forme Lulu.com à la version plus luxueuse fabriquée par des artisans du livre en nombre limité –, et des façons originales d’y accéder. Le livre numérique peut devenir un produit d’appel, gratuit, pour déclencher des ventes de livres imprimés. Le projet de Tim Devin d’impression de courriers électroniques distribués sur des pare-brise de voitures dans différentes villes des États-Unis est un exemple de la matérialisation d’objets numériques : un simple mail peut retrouver une figure d’autorité dès qu’il y a impression. Enfin, certaines publications imprimées ont évolué vers le numérique, c’est le cas de Boing Boing : ce fanzine (imprimé) connaît un succès important à la fin des années 1980 avant de cesser sa publication faute de distributeur ; une version web est alors créée quelques années plus tard, considérée comme un véritable pionnier du phénomène des blogs.

Post-Digital Print se referme sur la condition de cette hybridation : pour Alessandro Ludovico la métamorphose de l’édition est possible par le dépassement de toute « affiliation idéologique » (p. 180) liée aux medias imprimés ou numériques.

Post-Digital Print est un cas à part dans le domaine des ouvrages sur l’édition ou la publication numérique, cas qui pourrait se rapprocher de 6|5 d’Alexandre Laumonier – consacré au trading à haute fréquence sous le prisme du développement des moyens de communication. Pour mieux comprendre et étudier un sujet il faut bien évidemment analyser et interroger son progrès historique, ainsi Alessandro Ludovico retrace l’évolution technique de l’édition en illustrant ses propos de descriptions d’expérimentations souvent méconnues : des procédés comme la machine miméographique facilitant la reproduction d’imprimés clandestins ou des premières revues de science-fiction ; la mise en réseau permettant une distribution plus large avec le projet Whole Earth Catalog ; la technique d’impression offset avec l’apparition de revues comme Village Voice ou San Francisco Oracle aux mises en page plus audacieuses ; la photocopieuse amorçant le mouvement des fanzines ; ou le passage au tout numérique pour certains journaux à partir de l’année 2008.

Parmi les expérimentations que nous pouvons observer depuis 2012 à la suite de l’écriture de cet essai, voici quelques exemples choisis de façon subjective et reflétant les propos d’Alessandro Ludovico :

- la réédition de Flatland d’Edwin A. Abbott par Epilogue (Kehe, 2016) combinant un objet imprimé de grande qualité et un programme générant des formes en rapport avec le livre ;

- Zeitgeist de Frank Adebiaye (Fauchié, 2013) offrant deux lectures complémentaires, dont une numérique et aléatoire ;

- La dette technique de Bastien Jaillot et Design d’icônes : le manuel de Sébastien Desbenoit aux éditions Le train de 13h37 associant tous les deux la souscription avant publication et des versions imprimée et numérique ;

- Atomic Design de Brad Frost (Frost, 2016) donnant la possibilité de suivre l’écriture du livre et d’y contribuer ;

- la revue From–To de l’ÉSAD Grenoble Valence (Fauchié, 2015) avec un site web librement accessible et mis à jour régulièrement, et un livre imprimé au format et au prix réduits.

C’est avec une grande acuité que cet essai donne un aperçu clair de ce qui a été entrepris, et une perspective ouverte du territoire à explorer. Post-Digital Print parvient à articuler plusieurs axes déterminants pour l’édition, cette volonté d’embrasser la multitude des mutations de l’édition est relativement rare dans les ouvrages théoriques de ce domaine, généralement orientés vers une problématique principale – que ce soit Après le livre de François Bon, Le livre à l’heure numérique de Françoise Benhamou, Read/Write Book : Le livre inscriptible, ou encore Pratiques de l’édition numérique de Michael Sinatra et Marcello Vitali-Rosati. Alessandro Ludovico traite autant des aspects de design et d’usage, des enjeux de diffusion et de distribution, de la mise en réseau des acteurs de l’édition, de la recherche de stratégies économiques originales, et enfin des démarches d’archivage et d’accès. Lire et partager Post-Digital Print ouvre des perspectives pour la publication d’aujourd’hui et de demain.

1.1.4. Les chaînes de publication comme moyen d’une hybridation

Les réflexions d’Alessandro Ludovico nous permettent d’entrevoir un des éléments qui pourrait faire advenir cette hybridation. Un des enjeux de la mutation du texte – plutôt que du livre – se situe au niveau des moyens de conception et de production. La chaîne de publication, sujet peu abordé de façon frontale par Alessandro Ludovico, serait l’un des points de convergence des différentes dynamiques présentées dans Post-Digital Print : mutation de l’imprimé plutôt que fin du papier, expérimentations éditoriales grâce aux améliorations techniques, transformation du papier, édition numérique, archivage et réseau. Si l’hybridation est la réalisation de l’« impression postnumérique » (p. 178), comment cette hybridation peut-elle être réalisée ? Penser une chaîne de publication libérée d’« affiliation idéologique » (p. 179), capable de générer des formes et des formats tant pour le papier que pour le numérique, et en capacité de nourrir des ressources connectées, serait une solution.

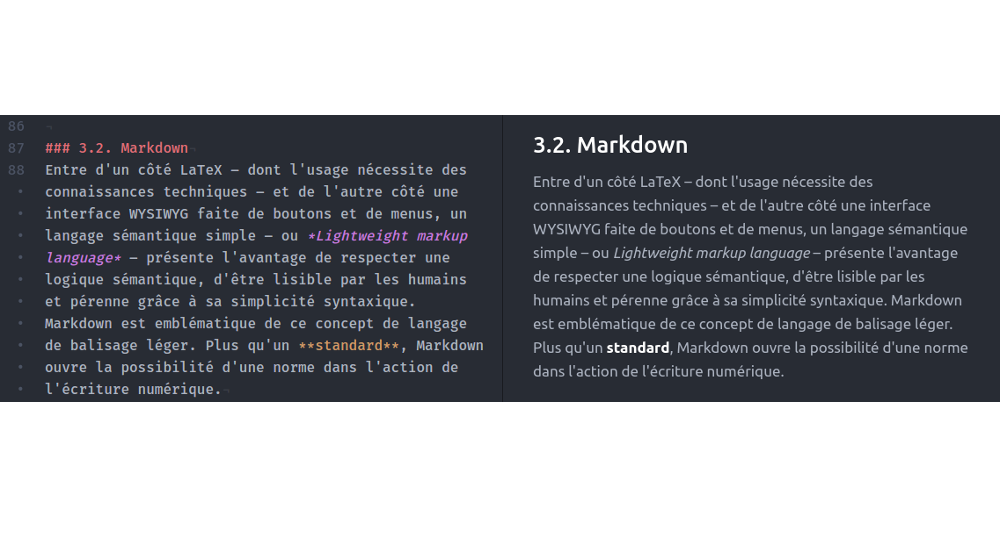

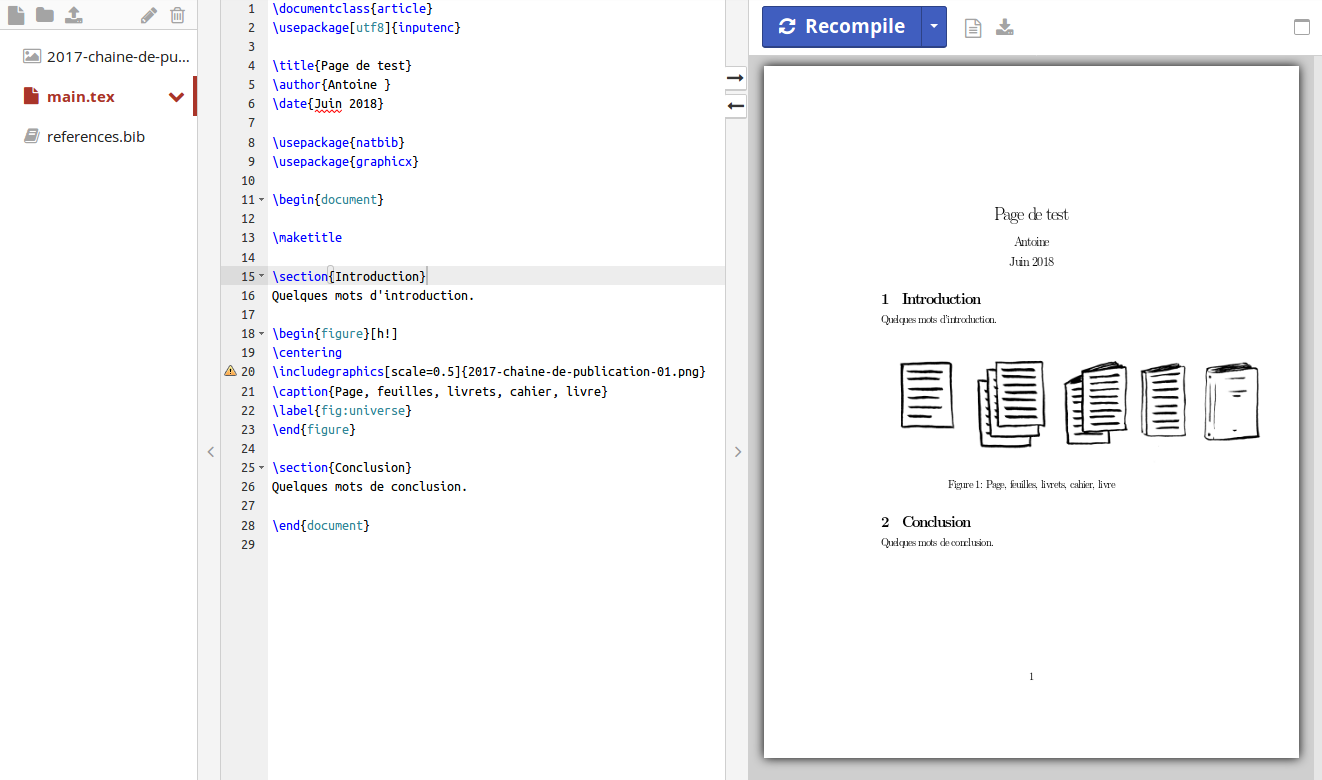

Une chaîne de publication inspirée du web (Fauchié, 2017) correspond à un ensemble modulaire de technologies et de méthodes issues du développement web, et permet de se passer du duo classique de l’édition : traitement de texte et logiciel de publication assistée par ordinateur. Il est trop tôt pour développer précisément ce concept, mais nous pouvons déjà le décrire : il s’agit de l’association d’un langage de balisage léger permettant de se passer de logiciel particulier pour écrire et structurer des contenus, d’un système de contrôle de version pour travailler à plusieurs sur un texte, et de la génération de formats multiples – du PDF pour l’impression à l’EPUB en passant par du HTML pour une version web. Cette chaîne est l’outil qui concrétise, ou tout du moins ouvre la possibilité de concrétiser la thèse d’Alessandro Ludovico. Une modularité ne restreint pas la chaîne d’édition à la génération d’un seul format. Des technologies ouvertes limitent l’« affiliation idéologique » de l’outil, et suppriment la dépendance à des logiciels en particulier – eux aussi porteurs d’idéologie, les traitements de texte et les outils de publication assistée par ordinateur sont avant tout pensés pour l’imprimé. Les formats utilisés dans ce workflow assurent une pérennité et un archivage des productions. La gestion des fichiers et des échanges avec un système de contrôle de version est une mise en réseau dès la conception et la production.

Loin de nous l’idée de détourner la thèse d’Alessandro Ludovico, les chaînes de publication ne sont qu’un point soulevé indirectement par son ouvrage, mais aujourd’hui il s’agit d’un nœud déterminant pour le texte, le livre, l’action de publier. L’auteur de Post-Digital Print pose un certain nombre de faits marquants et analyse des mutations essentielles de l’imprimé, il esquisse et même établit les évolutions possibles du texte.

1.2. Solutionnisme

Evgeny Morozov est un chercheur et écrivain d’origine biélorusse, dont l’objet de recherche principal est le « problème technologique »6. Collaborateur de plusieurs revues et auteur pour des journaux comme le New York Times ou El Pais, il a enseigné à l’Université Stanford et il est membre d’un certain nombre de fondations engagées dans la critique de la technologie ou l’évolution des processus démocratiques. Pour tout résoudre cliquez ici (Morozov, 2014) est publié en 2013 – 2014 pour la traduction française – et fait suite à The Net Delusion : The Dark Side of Internet Freedom publié en 2011. Evgeny Morozov y prolonge sa critique d’une vision d’Internet idyllique voire fantasmée, non pas dans une démarche technophobe, mais plutôt dans une tentative d’esprit critique et philosophique visant à interroger en profondeur nos conceptions, usages et perceptions de la technologie dans un monde désormais imprégné de numérique. Nous devons noter le caractère grand public de cet ouvrage, Pour tout résoudre cliquez ici n’est pas un travail universitaire à proprement parler, quand bien même Evgeny Morozov construit sa pensée de façon méticuleuse et référence nombre de penseurs et d’ouvrages.

Au moment de la publication de cet ouvrage7 Evgeny Morozov est clairement en opposition à une majorité – au moins médiatique – enthousiaste des technologies numériques et d’Internet : entrepreneurs, ingénieurs, intellectuels et chercheurs, souvent en lien avec la Silicon Valley. Evgeny Morozov peut parfois être perçu comme un trouble-fête dans un univers numérique à l’apparente pensée homogène, ce livre a justement suscité un débat parmi les défenseurs du solutionnisme ou même de la part d’autres critiques des technologies (Wu, 2013). Il incarne la figure d’une critique peut-être trop rare qui nous pousse à dépasser les arguments marketing de la dernière application à la mode, ou à porter un regard nouveau sur nos usages quotidiens des technologies.

Dans cet essai, Evgeny Morozov aborde le concept de « solutionnisme », qui peut être grossièrement résumé en la simplification d’un problème pour y appliquer des solutions prêtes à l’emploi, sans réelle prise en compte du contexte. Ce solutionnisme, au contact des technologies numériques et d’Internet en première ligne, se meut en « webcentrisme », qui consiste en l’application d’Internet à n’importe quel problème ou défi majeur – de la réduction des déchets à l’amélioration de la démocratie. Evgeny Morozov critique le solutionnisme en général et le « webcentrisme » en particulier, qui sont pour lui des conséquences directes d’un manque de réflexivité envers les technologies, de l’absence d’approche philosophique de la technique, ou d’une recherche béate de l’efficacité maximale. Le solutionnisme conduit à une évolution de l’humain alors considéré comme une machine optimisable, tout comme son environnement ; l’autonomie d’êtres – pourtant doués d’intelligence – est tout simplement en voie de disparition. Loin de s’opposer à la technologie, Evgeny Morozov souhaite en défendre une autre conception, et un recours qui ne devrait pas être systématique.

Pour tout résoudre cliquez ici est constitué de neuf chapitres, les deux premiers présentent le « solutionnisme » et le « webcentrisme », concepts qu’Evgeny Morozov critiquera ensuite dans les six chapitres suivants à travers des analyses thématiques : l’ouverture de l’administration par la publication de documents jusqu’ici peu visibles, l’évolution de la politique et de son fonctionnement, l’usage des données personnelles via des algorithmes, la gestion du crime avec les technologies numériques, et l’exploitation des données personnelles et ses conséquences avec le transhumanisme. Le dernier chapitre est une synthèse des critiques formulées dans les parties précédentes. Nous nous concentrerons ici sur les deux premiers et le neuvième chapitres, et nous analyserons ensuite les processus de publication avec les outils critiques mis à disposition par Evgeny Morozov.

1.2.1. Une critique du solutionnisme

Dans le premier chapitre de Pour tout résoudre cliquez ici, Evgeny Morozov présente plusieurs projets conçus pour répondre à des problèmes importants, chacun reposant sur des technologies de mesures connectées à Internet. Dans ces exemples les solutions semblent ingénieuses, simples, et efficaces. Mais, systématiquement, l’homme et son environnement sont limités à quelques données mesurables et modifiables. Les « innovateurs » – comme les appelle Evgeny Morozov – à l’origine de poubelles connectées ou de gestion du traffic grâce aux téléphones intelligents, trouvent des solutions techniques à des problèmes complexes, mais en simplifiant ces problèmes. Nous sommes là dans des cas de « solutionnisme », et par « solutionnisme » Evgeny Morozov entend : limiter les « situations sociales » pour pouvoir les perfectionner, bien souvent dans une démarche de recherche de résultats rapides et visibles, à court terme. « Ce qui pose problème n’est pas les solutions qu’ils proposent, mais plutôt leur définition même de la question. » (p. 18) La position des solutionnistes présente un autre écueil en plus de simplifier dangereusement : trouver des problèmes là où il n’y en a pas.

Pour critiquer le solutionnisme, Evgeny Morozov fait référence à plusieurs penseurs modernes ou contemporains : Ivan Illich8 à propos des systèmes d’enseignement, Jane Jacobs9 à propos de l’urbanisme, Michael Oakeshott10 à propos des rationalistes, Hans Jonas11 à propos de la cybernétique, James Scott12 concernant la démocratie, ou encore Albert Hirschman13 et son système de trois variations – effet pervers, inanité et mise en péril. Le point commun entre ces penseurs est qu’ils considèrent tous que les solutionnistes ont une faible compréhension de leur environnement, de « la nature humaine » (p. 20). Evgeny Morozov insiste sur le fait que sa critique du solutionnisme ne consiste pas en une peur de l’échec – une mauvaise solution à un problème pourrait avoir des conséquences néfastes –, mais en deux constats : premièrement le solutionnisme détourne le problème initial pour pouvoir trouver une solution ; deuxièmement le solutionnisme remplace la décision – ou l’indécision – par des calculs, des prévisions, des mesures, des process de surveillance. L’humain devient alors robot asservi. La fin de la deuxième partie de ce premier chapitre se conclut sur cet énoncé limpide : « Le rejet du solutionnisme n’est pas celui de la technologie. » (p. 26)

L’objectif d’Evgeny Morozov est de démonter le solutionnisme : celui-ci a été grandement développé ces trente dernières années par « l’internet », ce concept souvent mal défini, et qui a pris plus d’ampleur encore avec le « webcentrisme » (p. 28). Le « webcentrisme » est la tendance à placer Internet au centre de tous les discours et de tous les projets, sans forcément bien circonscrire ce concept de réseau de réseaux. « Révéler le webcentrisme pour ce qu’il est facilitera grandement l’entreprise de discrédit du solutionnisme. » (p. 28) Ainsi Evgeny Morozov introduit le deuxième chapitre de son livre.

1.2.2. Le « webcentrisme » est le solutionnisme contemporain

Le second chapitre de Pour tout résoudre cliquez ici débute avec une double critique d’Internet : Internet est flou, même pour les médias spécialisés dans la technique/technologie ; Internet est sacré, pour ceux qu’Evgeny Morozov appelle les « geeks ». Aujourd’hui, Internet intègre toute technologie et aspire n’importe quelle innovation, jusqu’à former une bouillie informe impossible à définir précisément, mais pourtant bien maîtrisée – en apparence – par certains. Le problème est autant la définition d’Internet, que celle des usages qui y sont liés, et Evgeny Morozov de prendre l’exemple de Nicholas Carr qui est enfermé dans une vision monolithique : il n’y a pas un « net », Internet est plus complexe que la vision fantasmée de l’auteur de The Shallows: What the Internet is Doing to Our Brains14. Evgeny Morozov parle même d’« entité mythique » (p. 33) à propos de la vision qu’ont certains d’Internet, provoquant une vision binaire, dichotomique : il n’y a pas d’avant et d’après, cette évolution est diffuse, moins brusque qu’il n’y paraît. « Tous ces penseurs considèrent « l’internet » comme une entité à la fois unique et stable, significative et instructive, puissante et indomptable. » (p. 35) Nous devons porter un regard critique sur ce que nous considérons comme acquis : par exemple l’ouverture supposée de Google ou l’invisibilité administrative présumée de Wikipédia se révèlent autre si nous questionnons mieux et si nous prenons le temps de définir, avec « humilité » (p. 41).

Le « webcentrisme » regroupe des personnes ayant un même comportement caractéristique qu’Evgeny Morozov nomme l’« époqualisme ». Ainsi, les optimistes ou les pessimistes des innovations affirment l’existence d’une révolution sans l’expliquer, la justifier ou la comparer avec d’autres faits historiques. Ils ne convoquent pas l’histoire. Evgeny Morozov prend plusieurs exemples passés de systèmes qui ont été repris avec Internet : du crowdsourcing pour les cartes anglaises au dix-huitième siècle à la refonte d’un logo en 1936. Globalement ce que tente d’expliquer – avec quelques effets de répétition – Evgeny Morozov, c’est que le « webcentrisme » induit de tout vouloir expliquer au prisme d’Internet, sans esprit critique. Alors que conserver un esprit critique ne veut pas dire tout rejeter, au contraire. « Dans un pur esprit dialectique hégélien, le webcentrisme se maintient entre les deux pôles binaires que sont le pessimisme et l’optimisme d’Internet, faisant passer toute critique à son encontre pour une manifestation supplémentaire de ces deux extrêmes. » (p. 52) Pour poser les termes d’une révolution, il faut tenir compte de « deux critères » : il ne faut pas omettre ce qui s’est passé avant – au risque de défendre une pensée « anhistorique » (p. 53) –, et il faut s’appuyer sur le contexte contemporain global de cette supposée révolution – au risque de mal comprendre des phénomènes que nous pouvons pourtant observer. Mais alors n’y a-t-il pas des changements notables avec Internet ? Oui, mais le changement n’a pas été aussi brusque que nous pourrions le penser, il n’y pas eu de réelle rupture, comme d’ailleurs plus globalement dans l’histoire de la pensée.

Dans l’avant-dernière partie de ce deuxième chapitre, Evgeny Morozov prend l’exemple de l’imprimerie pour noter combien certains penseurs ont fait des comparaisons maladroites entre Internet et d’autres révolutions techniques et sociales. Par exemple Clay Shirky15 développe toute une argumentation autour des effets sociaux et économiques des technologies d’Internet, argumentation basée sur une théorie d’Elizabeth Eisenstein16 concernant l’imprimerie et la presse : celles-ci seraient à l’origine d’une ère totalement nouvelle, et de la même façon les bouleversements engendrés par Internet seraient sans précédent. Mais cette théorie a elle-même des limites, Elizabeth Eisenstein a tenté de marquer plus fortement une rupture qui existait mais qui n’était pas si nette, fruit d’évolutions successives :

Les limites de l’approche d’Eisenstein ont été soulignées par de nombreux universitaires et demeurent très pertinentes dans le débat actuel sur internet. Le premier à tirer le signal d’alarme, en 1980 (soit un an après la publication du livre) fut l’intellectuel et historien Anthony Grafton. Il vilipenda Eisenstein pour avoir « tirer de ses sources les faits et déclarations semblant répondre à ses besoins polémiques immédiats ». (Morozov, 2014, p. 61)

La conclusion de ce second chapitre consacré au « webcentrisme » est la suivante : le webcentrisme est l’expression contemporaine et l’outil du solutionnisme, il entraîne une absence de regard critique sur les technologies. Pire, il alimente une recherche aveugle d’efficacité, et déclenche des expérimentations basées sur celle-ci. Si le « webcentrisme » a d’une certaine façon aidé des combats militants, il a du même coup entraîné une perte de « clarté d’analyse » et de débat. Pour Evgeny Morozov le « webcentrisme » s’approche d’une religion, pour le critiquer il faut revenir aux bases, oublier ce que nous savons : les chapitres suivants sont consacrés à cette entreprise. « Le fait que ce webcentrisme nous coupe de la réalité est un motif d’inquiétude, non de réjouissances. » (p. 69)

1.2.3. Une critique en pratique

Le neuvième chapitre de Pour tout résoudre cliquez ici est un condensé des six chapitres précédents, ceux-ci présentant des analyses de cas de solutionnisme et de webcentrisme. Evgeny Morozov commence ce dernier chapitre en présentant le projet d’un parcmètre « intelligent » qui permet de mesurer l’usage des places de parking à Santa Monica, et d’améliorer le système de stationnement. Evgeny Morozov y applique les principes d’Albert Hirschman : inanité, effet pervers et mise en péril. Ce projet présente ces trois risques, puisque l’objectif final n’est pas l’amélioration de la ville en cela qu’elle est l’amélioration des citoyens et de leur situation – en tant que ceux-ci auraient la possibilité d’exprimer un choix, de décider – mais cet objectif est uniquement celui du profit financier de la Ville. Il ne suffit pas de relever les points facilement résolubles d’un problème, mais il faut considérer le problème dans toute sa complexité, et chercher à redéfinir les causes et les effets « en terme de relations, structures, et processus. » « Le vrai problème avec le système de Santa Monica n’est pas qu’il soit intelligent, mais qu’il ne le soit pas suffisamment. » (p. 314)

Là où nous nous trompons, c’est sur le fait de vouloir distinguer les solutions techniques d’un côté et les questions éthiques, sociales ou morales de l’autre. Les deux sont forcément imbriquées. Et Evgeny Morozov d’évoquer Jacques Ellul comme grand défenseur de cette séparation de la « moralité » et de la « technologie » : « Il est temps d’abandonner ce discours sur la « Technologie » avec un T majuscule pour nous consacrer plutôt à découvrir de quelle manière d’autres technologies peuvent favoriser ou nuire à la condition humaine. » (p. 315) Là où Jacques Ellul considère l’homme comme soumis à une technique désormais hors de contrôle, celle-ci ayant dépassé le simple statut de moyen ou d’outil, Evgeny Morozov soutient qu’il faut dépasser ce constat et s’organiser pour chercher et trouver les meilleures solutions, sans vouloir rejeter la technologie par principe. Il faut prendre en compte que les humains que nous sommes et le monde que nous habitons ne sont pas optimisables comme des machines : le niveau de complexité des solutions est proportionnel au contexte des problèmes auxquelles elles répondent. La technologie peut aussi proposer un choix à l’humain qui l’utilise, et donc déplacer la solution : non plus dans un fonctionnement technique binaire – appuyer sur un bouton – mais comme processus de décision que va prendre un être conscient et réfléchissant. Evgeny Morozov présente plusieurs exemples qui vont dans ce sens, notamment des « appareils erratiques » ou des « produits transformationnels » (pp. 317 et 319).

Evgeny Morozov aborde le fonctionnalisme – probablement pour dépasser le solutionnisme – et le définit ainsi : les objets technologiques ont des fonctions et des objectifs, il s’agit alors de chercher à concevoir et produire des objets qui expriment cela le plus fortement possible. Le fonctionnalisme pousse les concepteurs, les designers, à ne pas penser des objets « initiateurs de débats » (p. 320). Pour Evgeny Morozov il faut modifier les objectifs du fonctionnalisme – et donc indirectement ceux du solutionnisme : non plus chercher le meilleur et le plus efficace des objets technologiques pour effectuer telle tâche, mais permettre une relation entre la machine et son utilisateur qui donne lieu à une solution. Et c’est là le rôle du designer que d’ouvrir un dialogue entre l’objet et son utilisateur via l’interrogation de l’origine de cet objet et des usages causés par ce dernier. Le design, par le biais de ces « artefacts », doit susciter une discussion qui mènera aux solutions via des usages non prévus ou insoupçonnés. Pour prolonger sa réflexion Evgeny Morozov prend un détour avec des exemples dans le domaine de l’économie d’énergie. À travers ceux-ci, il nous incite à passer d’une « conscience pratique » à une « conscience discursive » (p. 324) : la conscience pratique correspond à une mesure de nos consommations, à un rapport assez rationnel avec la technologie, alors que la conscience discursive correspond à une « introspection » à la fois personnelle et collective.

Internet, en tant qu’il est désormais le vecteur le plus important de l’information, n’est-il pas trop fonctionnaliste, et notamment à travers les services et outils qui nous permettent de l’utiliser ? Evgeny Morozov compare donc le fait de laisser un objet électrique en veille et le fait de consommer de l’information à outrance via de nombreux agrégateurs et fermes de contenus. Il est possible de rendre visible notre consommation d’information et son impact, alors pourquoi ne pas le faire ? Moralité et prise de décision ne sont pas des denrées limitées comme le pétrole, comme veulent nous le faire croire nombre de penseurs solutionnistes, mais plutôt des éléments qui s’auto-génèrent à mesure que nous en créons. Il ne faut plus faire appel à la psychologie à travers le solutionnisme, mais plutôt à la philosophie. Ainsi la question du choix est centrale : nous pouvons avoir l’impression de choisir – par exemple entre un produit de grande distribution et un produit bio –, alors que notre choix n’aura que peu d’incidence sur un plan global, et encore moins sur nous puisqu’il n’y aura plus de prise de conscience accompagnant ce choix.

La sérénité, l’absence de conflit et l’absence de faille sont une influence de ceux qu’appellent Evgeny Morozov les « geeks » : la technique pouvant être optimisée continuellement, pourquoi ne pas faire la même chose avec l’humain ? L’exemple de la vie privée permet de comprendre que la contrainte peut être une bonne chose : « Le but de la vie privée n’est pas de protéger un soi stable de l’usure, mais de créer des frontières entre lesquelles il puisse jaillir, évoluer et se stabiliser. En d’autres termes, les limites et les contraintes peuvent être productives, bien que toute l’arrogance de « l’internet » suggère le contraire. » (p. 337) Au risque de nous répéter, la perte d’autonomie ne semble pas problématique lorsque c’est pour une bonne cause – Evgeny Morozov prend l’exemple de l’économie d’énergie –, mais il y a pourtant un double « écœurement » : la « ruse » utilisée pour nous convaincre d’agir ainsi, et le fait que nous ayons l’impression d’avoir une autonomie dans ce choix. « Tenter d’améliorer la condition humaine en supposant tout d’abord que les personnes sont comme des robots ne nous mènera pas bien loin. » (p. 340)

La conclusion de ce chapitre, qui est également la conclusion de Pour tout résoudre cliquez ici, prend la forme d’un avertissement et d’une ouverture : si le principal défaut des ingénieurs est de reconsidérer perpétuellement les situations – « Pour eux, tout est négociable, y compris la dignité et l’autonomie. » (p. 342) –, alors il faut réintroduire de l’irrationalité, des débats, des délibérations, des questionnements dans la façon dont nous concevons et nous utilisons la technologie. Le solutionnisme doit intégrer du doute pour dépasser ses propres limites.

1.2.4. Esprit critique et question du choix

Pour tout résoudre cliquez ici s’inscrit dans un mouvement de pensée minoritaire lorsqu’il est publié en 2013, Evgeny Morozov se positionnant résolument contre une partie des innovateurs et des essayistes des nouvelles technologies, et cela sur le même terrain : Pour tout résoudre est en effet un livre destiné au grand public, nous n’avons pas affaire à un travail purement universitaire. Comme il le démontre lui-même il n’est pas seul à remettre en cause une certaine approche de la technique et de la technologie, ses références sont autant des chercheurs contemporains que des intellectuels des vingtième et dix-neuvième siècles. Sa proximité avec ces courants est principalement philosophique, en cela que la philosophie cherche à définir précisément une question, avant même de répondre à cette question. Derrière des propos qui semblent souvent pessimistes, négatifs voir alarmistes, Evgeny Morozov construit une vision de la technique proche de celle du philosophe Gilbert Simondon : la technique n’est pas mauvaise en soi, mais c’est notre rapport avec elle qu’il faut reconsidérer. Le constat froid et alarmiste d’une technique qui assujettit l’homme doit être dépassé par une nouvelle considération de la technique et de son application : nous devons nous repositionner par rapport à la technologie. Le penseur d’origine biélorusse va plus loin : les designers et les ingénieurs ont le choix de concevoir des objets, des artefacts ou des systèmes qui ne considèrent pas l’humain comme un robot, de laisser de côté le solutionnisme et le « webcentrisme » pour se concentrer sur des approches techniques véritablement humaines.

1.2.5. Des processus de publication solutionnistes ?

Nous allons projeter la critique du solutionnisme d’Evgeny Morozov sur un objet qui, contrairement au domaine choisi dans Pour tout résoudre cliquez ici, n’est pas directement social : prenons les processus et les outils de publication. Actuellement, les logiciels les plus utilisés par les maisons d’édition sont les traitements de texte et les logiciels de publication assistée par ordinateur. Quels sont les objectifs de ces outils ? Faciliter le travail de publication, qui consiste en plusieurs tâches : la structuration de contenus, les interactions sur un texte, la mise en forme, la génération des formats permettant une diffusion papier ou numérique, et l’archivage des fichiers de travail. Les logiciels en question sont conçus pour être relativement simples d’utilisation, masquant des aspects pourtant importants : distinction du fond et de la forme, compréhension des enjeux liés à certains formats, qualité du code dans le cas du livre numérique, etc. L’utilisation d’un logiciel de publication assistée par ordinateur ou d’InDesign – pour le citer –, se fait donc presque à l’aveugle, si nous prenons en compte qu’il s’agit uniquement d’une relation entre une interface et un utilisateur, et que le fonctionnement de cette interface reste opaque. Remettre en cause ces processus ne consisterait pas à complexifier des tâches qui n’auraient pas besoin de l’être, mais à replacer de la transparence dans des procédés nécessitant une compréhension et une réflexivité.

Si les besoins d’une maison d’édition peuvent différer selon sa spécialité, les outils restent globalement les mêmes – ce qui peut paraître étonnant en comparaison d’autres métiers –, et par ailleurs les évolutions des logiciels en question sont unilatérales : il n’y a pas de retour en arrière possible lors d’une mise à jour par exemple. Un même outil cherche à résoudre des problèmes très différents et tente de s’adapter à tout type de situation : il finit par faire mal les choses, et à imposer de mauvais mécanismes. Nous retrouvons les traits du fonctionnalisme, et dans certains cas d’utilisation il s’agit même de solutionnisme : la recherche d’efficacité masque les objectifs initiaux de tels outils. Les solutions mises en place visent à résoudre les problèmes les plus évidents, simplifiant et éludant jusque l’une des composantes essentielle de l’édition : la différenciation entre la structure – le texte lui-même et les valeurs qui lui sont attribuées – et la mise en forme – les caractéristiques graphiques attribuées à la structure. La marge de décision de l’utilisateur est presque inexistante. Il faut pourtant que l’objet technique provoque une réflexion chez l’utilisateur, et ainsi que ce dernier résolve un problème. C’est bien dans cette relation avec l’utilisateur qu’un problème peut être résolu, et non en appuyant sur un bouton. Les traitements de texte et les logiciels de publication assistée par ordinateur sont clairement du côté du choix rationnel : la première contrainte est de résoudre un problème – concevoir et produire un livre, donc publier –, quand bien même ce problème n’est pas défini – en quoi consiste exactement publier ? Le recours à un logiciel monolithique comme InDesign oblige à enfermer sa vision dans un processus et pas dans un autre.

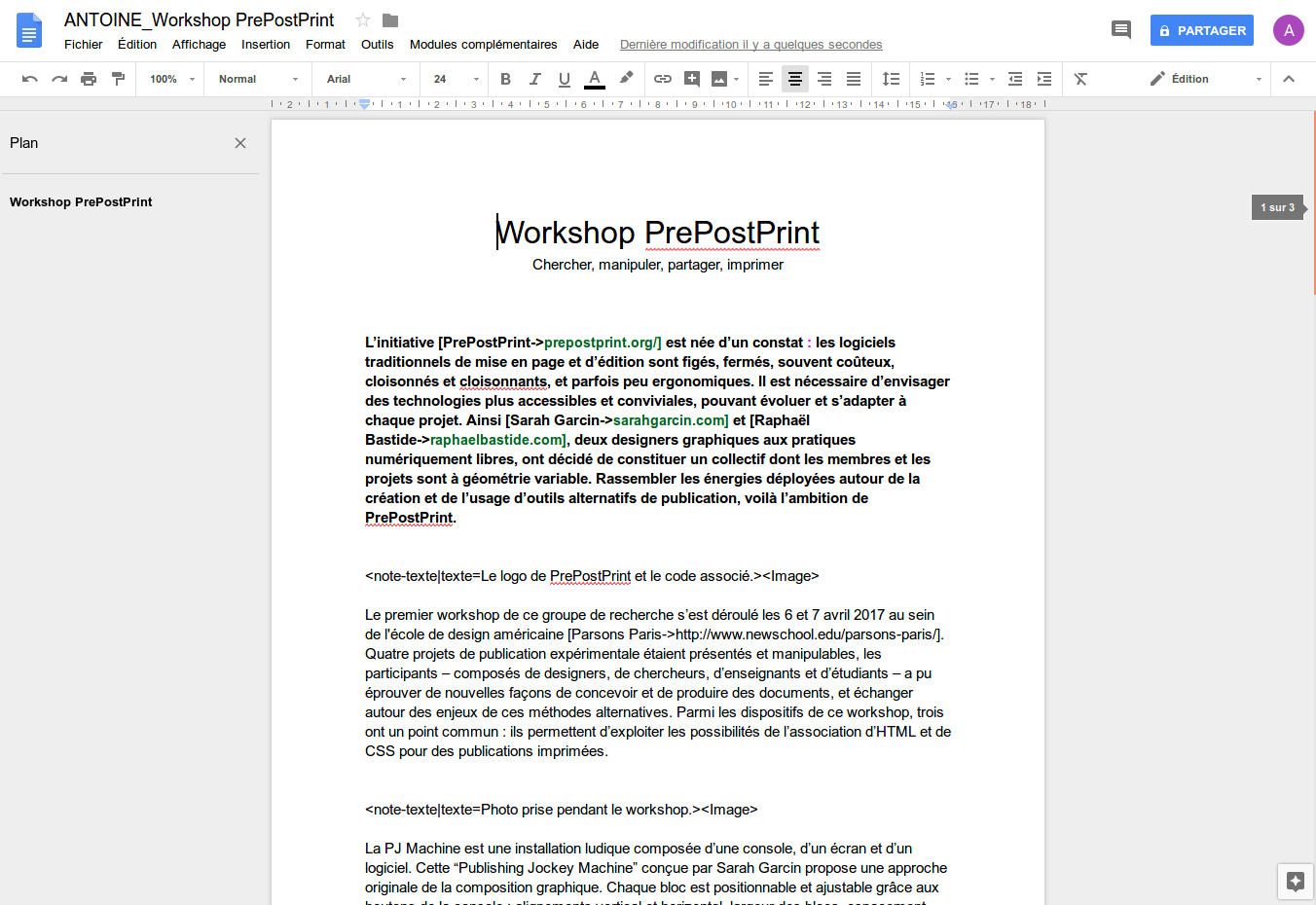

L’automatisation de certaines étapes d’une chaîne de publication est nécessaire, des outils adaptés sont donc incontournables pour un éditeur. Mais, en plaçant la convivialité ou la modularité comme principe de départ, d’autres modes de fonctionnement sont possibles, qui ne visent pas l’efficacité directe de l’outil mais la maîtrise de l’activité de publication. La constitution du collectif PrePostPrint (Fauchié, 2017) est une initiative qui va dans ce sens, l’exemple le plus marquant porté par cette démarche de recherche et de démocratisation est l’utilisation des langages HTML et CSS pour fabriquer et produire des publications imprimées, aussi appelée HTML2Print. HTML et CSS sont des standards : l’un est conçu pour structurer des contenus, et le second pour déterminer une mise en forme à partir de la structure. Le recours aux technologies du web dans ces cas n’est pas une application du « webcentrisme » à la publication, mais plutôt l’utilisation réfléchie et adéquate d’une technologie dans une situation et une période données. Par ailleurs ce type de procédé implique un travail de conception, d’apprentissage et de remise en cause régulière, donc de l’humain là où les chaînes de publication sont actuellement surtout composées de logiciels.

Par ailleurs, au-delà du choix technologique – logiciel ou langages HTML et CSS – il faut mentionner celui de la forme des collaborations. PrePostPrint, ou des initiatives préexistantes comme les workshops d’Open Source Publishing17 ou d’autres structures, sont autant des temps destinés à la conception et à la production, et basés sur des procédés originaux, que des occasions qui portent des discussions et des échanges autour de problèmes et de solutions. L’objectif n’est pas uniquement de produire, mais de permettre un débat, débat qui peut par ailleurs se prolonger sous d’autres formes – via des sites web, du partage de code, etc.

Evgeny Morozov nous donne des clés pour construire une critique d’un solutionnisme présent dans notre rapport aux technologies, y compris dans le domaine de l’édition. Remettre en cause des processus opaques n’est pas une position négative qui rejette toute solution technique, mais la possibilité de ré-introduire de l’humain et de rechercher la meilleure solution à un problème en fonction du contexte. Meilleur au sens où la maîtrise et la liberté de choix doivent être conservés, où l’humain doit être au centre des procédés, et où la remise en cause doit être permanente, si ce n’est perpétuelle. La pensée de Gilbert Simondon, comme nous l’avons déjà évoquée, précède et prolonge ces réflexions, nous l’analysons dans la prochaine partie.

1.3. Progrès technique

Gilbert Simondon est un philosophe français né en 1924 et mort en 1989. Philosophe de la technique, mais également professeur de psychologie et de physique, il a une démarche résolument encyclopédique. Du mode d’existence des objets techniques (Simondon, 2012) est sa thèse complémentaire qu’il soutient en 1958 et qui est publiée la même année, dans laquelle il aborde la condition des objets techniques au même titre que les objets sacrés ou les objets esthétiques, pour construire une culture technique comme mode de rapport au monde de l’homme. Ce texte est probablement le plus connu du philosophe, même si une vingtaine d’ouvrages ont été publiés, souvent posthume, dont : L’Individu et sa genèse physico-biologique, L’individuation psychique et collective, Sur la technique, Sur la psychologie, ou Sur la philosophie.

Encore étudiée et citée aujourd’hui, l’œuvre de Gilbert Simondon a marqué notre époque et a influencé des penseurs comme Gilles Deleuze, de nombreux philosophes contemporains comme Bernard Stiegler ou Pierre-Damien Huyghe s’y réfèrent directement. Gilbert Simondon est en quelque sorte un héritier de Marx (« Séminaire Simondon et Marx, technique et politique », 2012), et prolonge les pensées de Gaston Bachelard et Henri Bergson (Barthélémy, 2008). Du mode d’existence des objets techniques, ou MEOT, représente en soi une révolution philosophique du vingtième siècle, Gilbert Simondon s’opposant à la plupart des penseurs techniques – dont Martin Heidegger qui ne pense pas la technique à partir de la catégorie de l’objet (Portis-Guérin & Berger, 2016).

MEOT est composé de trois parties : la première est consacrée à l’objet technique sous l’angle de sa genèse et de son évolution ; la seconde partie se concentre sur le rapport de l’homme et de la technique, notamment en traitant des questions d’éducation, de formation et de progrès ; la troisième partie fonde la culture technique, base du rapport de l’homme au monde et à la nature. Nous nous concentrons ici sur la première partie Du mode d’existence des objets techniques, elle ouvre des perspectives passionnantes pour évaluer certaines technologies numériques du vingt-et-unième siècle, et y porter un regard critique.

1.3.1. Une critique de la technique

La question de la technique est encore abordée d’une façon dichotomique lorsque Gilbert Simondon écrit cette thèse : soit considérée comme purement utilitariste, soit sacralisée ou rejetée, la technique est détachée de la culture. La première partie Du mode d’existence des objets techniques traite de la question de l’objet technique afin de constituer, dans le reste de cet ouvrage, une culture technique comme nouveau socle du rapport de l’homme au monde. L’aliénation du monde contemporain n’est pas due à la machine, mais à une mauvaise reconnaissance de la technique. Notre civilisation est « mal technicienne » (Parent, 1968) : elle comprend mal la technique et ne se positionne pas de façon juste par rapport à elle. Nous ne pouvons que réaffirmer ce que Gilbert Simondon exposait il y a plus de cinquante ans : la technique est mal perçue, et pour mieux la comprendre l’auteur Du mode d’existence des objets techniques nous invite à définir l’objet technique en tant qu’être et en tant qu’individu. L’objet technique est la clé de cette nouvelle compréhension de la technique : il est doté d’une existence et d’une individualisation. Par ailleurs son analyse nous permet de définir ce qu’est le progrès technique.

Comment repositionner l’homme et la machine ? À travers un travail de définition et de genèse, Gilbert Simondon présente tout d’abord les conditions d’existence de l’objet technique dans le premier chapitre de la première partie : phénomène de concrétisation et mode d’évolution de l’objet technique. La question de l’individualisation occupe le deuxième chapitre : concept de milieu associé et forme de l’évolution technique. En déterminant le mode d’existence des objets techniques, Gilbert Simondon place les bases d’une culture technique qu’il développe dans les parties suivantes, que nous ne commentons pas ici.

Afin d’illustrer la pensée de cette première partie et de la replacer dans un contexte contemporain – un monde numérique –, nous nous attarderons sur un exemple d’objet technique qui nous intéresse particulièrement ici : les chaînes de publication, c’est-à-dire l’ensemble du processus de conception et de production de livres. Enfin, nous répondrons à deux questions essentielles. Comment dépasser une conception uniquement utilitariste de la technique, quelle peut être cette perfection interne des machines ? Le progrès technique ne peut-il pas être autre chose qu’une recherche effrénée vers l’efficacité et émanciper l’homme de son mauvais positionnement par rapport à la machine ?

1.3.2. La génèse de l’objet technique

Dans le premier chapitre de la première partie Du mode d’existence des objets techniques, Gilbert Simondon cherche à décrire l’objet technique suivant son évolution : en cherchant les liens entre un objet technique du passé et un objet technique du présent, nous découvrons une ontogenèse. Celle-ci s’appuie tout d’abord sur la définition du concept de « concrétisation » (p. 26), concept qui est l’une des conditions d’existence de l’objet technique. Nous pouvons considérer que l’objet technique a une « forme abstraite » (p. 24) lorsqu’il est dissocié de son environnement de fonctionnement, à l’inverse la concrétisation de l’objet technique se définit par l’imbrication des fonctions qui le composent, celles-ci peuvent former une synergie : les fonctions convergent.

Prenons l’exemple de l’ustensile : en soit il ne fait que répondre à un besoin précis, il est purement fonctionnel, sa ou ses fonctions sont chacune indépendante, son fonctionnement est linéaire – une fonction après l’autre –, il s’agit d’un objet technique abstrait. Prenons un second exemple : un moteur n’a pas un fonctionnement linéaire, ses éléments sont imbriqués, certaines fonctions se répondent entre elles, il y a une synergie interne au moteur, il s’agit d’un objet concret. En termes de genèse l’« objet technique abstrait » (p. 29) est primitif, ancien, il y a donc une évolution technique, mais comment s’est-elle déroulée ? Le progrès technique est brusque, il n’est pas continu, il est composé d’« évolutions mineures » (p. 46) et d’« évolutions majeures » (p. 46). Les évolutions mineures sont des améliorations : ajout d’une fonction augmentant l’efficience de l’ensemble, comme le fait de compléter une phrase par un appendice entre parenthèses. Les évolutions majeures s’appuient sur les évolutions mineures, elles se traduisent par de nouveaux objets techniques, comme le fait de reformuler une phrase pour la compléter, plutôt que de lui adjoindre une parenthèse : remplacer l’extension par une refonte.

Ce que nous pouvons en déduire, c’est que la perfection d’un objet technique ne correspond pas à son degré de résolution d’un problème, mais à la cohérence et la performance de son propre fonctionnement. Nous ne devons pas tomber dans une recherche de l’utilité pure qui nous obligerait à juger d’un degré de progrès technique en fonction de la simple réponse de l’objet technique à un problème que nous aurions posé. Il y a une forme de beauté interne de l’objet technique, que nous pourrions comparer à celle d’un organisme, même si un objet technique n’est pas vivant. Si nous parlons ici d’évolution technique, quelle forme prend-elle ? Le progrès technique est basé sur un double mouvement : les évolutions mineures, correctives, donnent lieu à des évolutions majeures, de nouveaux objets techniques ; il ne s’agit donc pas d’une genèse, mais d’une filiation ; les objets techniques sont liés entre eux et le progrès technique n’est pas une évolution continue, mais un processus discontinu dans lequel l’humain a un rôle clé.

La question soulevée à la fin de ce premier chapitre est la suivante : comment est permise cette évolution ? Quel est ce cadre inventé par l’homme et qui donne lieu à une concrétisation ?

1.3.3. L’individualisation de l’objet technique

Le second chapitre de cette première partie débute par la définition de l’« hypertélie » (p. 61) de l’objet technique, qui est un phénomène de spécialisation qui le rend moins adaptable, et moins autonome. L’hypertélie peut être de plusieurs ordres : spécialisation, division en vue d’une spécialisation, efficience en fonction de l’environnement extérieur. La plurifonctionnalité des objets techniques n’est possible que sans spécialisation des deux premiers types, elle est toutefois rendue possible dans un certain milieu, le troisième milieu : ni l’objet technique seul, ni son contexte. Il s’agit donc d’un équilibre entre deux milieux, permis par l’homme : le « milieu associé » (p. 70).

La particularité du milieu associé est qu’il est créé par l’objet technique et que ce milieu permet à l’objet technique d’exister : « Ce milieu à la fois technique et naturel peut être nommé milieu associé. Il est ce par quoi l’être technique se conditionne lui-même dans son fonctionnement. » (Simondon, 2012) Prévoir ce qui se passera dans une situation d’application – l’objet technique immergé dans un contexte particulier – est la condition permise par l’homme, un acte d’invention, nous pouvons considérer la « causalité récurrente » (p. 75) comme son expression visible. Cette forme d’autonomie, et donc cette individualisation, s’exerce au niveau de l’individu technique, et non au niveau de l’ensemble technique, ce dernier en héritant néanmoins, comme pour la causalité récurrente. Si Gilbert Simondon insiste sur ce point, nous pouvons noter que le caractère d’individualisation concerne l’individu technique et le niveau inférieur, l’élément technique, mais sans que ce dernier ne possède de milieu associé. Les éléments techniques ont un caractère d’individualisation uniquement parce qu’ils composent l’individu technique. Le passage de causalité se fait donc entre élément technique et individu technique, nous devons approfondir l’aspect temporel qu’implique ce passage et quelle différence il y a avec le vivant.

Dans le cas du vivant l’organe ne peut être détaché de l’ensemble, alors que l’élément technique peut être retiré de l’individu technique ; le vivant engendre à l’identique, alors que la technique produit. Le « temps de relaxation » (p. 83) est l’une des distinctions entre le vivant et la technique : comme nous avons déjà pu le voir le progrès technique est discontinu, en dents de scie. Gilbert Simondon introduit le concept de « production indirecte » (p. 88), que nous pouvons comprendre comme l’amélioration progressive qui donne lieu à des nouveaux objets techniques, c’est par le jeu de leurs imperfections que les objets techniques évoluent, contrairement aux êtres vivants qui, par leur perfection, engendrent des êtres identiques à eux. Nous pourrions ajouter une précision aux propos de Gilbert Simondon : les êtres vivants évoluent dans un temps long, ils ne sont pas parfaitement identiques lorsqu’ils s’engendrent, alors que les objets techniques connaissent des bons d’évolution.

La machine et l’homme sont très différents : la machine porte les outils et les dirige, et l’homme règle et dirige la machine. Le point commun entre la machine et l’homme réside dans la notion d’individu, qui peut être considérée comme l’auto-régulation, il y a l’idée d’un fonctionnement autonome. Par exemple la machine-outil ne fait qu’utiliser des outils, alors que l’objet technique est plus indépendant ; Gilbert Simondon fait également la distinction entre technicien et artisan pour appuyer cette précision. Partant du constat d’une part que les civilisations non-industrielles n’ont pas d’individu technique parce que c’est l’homme qui porte les outils, et d’autre part que les civilisations industrielles ont des individus techniques parce que l’homme devient celui qui permet l’auto-régulation des machines, nous devons alors nous interroger sur le niveau d’intervention de l’homme sur l’objet technique. L’homme était un individu technique, il ne peut donc intervenir dans l’individu technique, mais au-dessous – l’élément technique – ou au-dessus – l’ensemble technique.

Gilbert Simondon introduit la notion de « culture technique » et prévoit de l’expliciter dans les prochaines parties, en tant qu’elle permet de résoudre la confusion autour de l’individualisation de l’objet technique : il n’est pas humain, mais parce qu’il est individu l’homme croit que la machine a des propriétés humaines. « Il est nécessaire que l’objet technique soit connu en lui-même pour que la relation de l’homme à la machine devienne stable et valide : d’où la nécessité d’une culture technique. » (Simondon, 2012)

La pensée de Gilbert Simondon peut être considérée comme novatrice, l’analyse de la première partie nous en révèle déjà plusieurs raisons. Le statut d’objet technique est une nouvelle approche, contrairement à des courants de pensée moderne comme la philosophie de Martin Heidegger. Autre opposition avec Martin Heidegger, la conception de la technique présentée dans MEOT n’est pas une dépossession supplémentaire de l’homme, pas plus qu’elle est une simple supériorité de l’homme sur la nature comme le soutient Nietzsche. Parmi ses contemporains, nous pouvons noter la position de Jacques Ellul qui place dans la technique une dimension politique et morale, en tant qu’elle est la source de nouvelles aliénations, ce que réfute justement Gilbert Simondon. Ce dernier a également influencé nombre d’auteurs, nous pouvons citer Bernard Stiegler qui a bâti un concept d’« individuation » et de « transindividuation » (Stiegler, 2006) à partir d’une critique de Gilbert Simondon, ou Pierre-Damien Huyghe qui y fait référence dans plusieurs de ses travaux.

1.3.4. Un objet technique contemporain : les chaînes de publication

Pour illustrer les idées, les concepts ainsi que la thèse que Gilbert Simondon présente dans la première partie de son livre, nous choisissons un objet technique contemporain : les chaînes de publication.

Une chaîne de publication est l’ensemble des outils et méthodes qui forment le processus de conception et de production des livres, ou plus globalement des publications. Un exemple type est le couple traitement de texte et logiciel de publication assistée par ordinateur. A contrario les chaînes de publication qui utilisent les technologies et les méthodes du développement web peuvent représenter un progrès technique par rapport aux chaînes de publication classiques. Ces dernières utilisent des logiciels destinés à accomplir une tâche : d’un côté écrire du texte et éventuellement le structurer avec un traitement de texte, et de l’autre côté mettre en forme et produire un fichier permettant une impression papier avec un logiciel de publication assistée par ordinateur. Majoritairement propriétaires et fermés, le code de ces logiciels n’est pas accessible, modifiable ou partageable, plaçant ceux qui conçoivent et fabriquent les livres dans une situation d’aliénation imposée. Par exemple si un logiciel comme InDesign ne prend plus en charge GREP – système d’expressions régulières permettant de faciliter les remplacements en série –, alors l’éditeur qui l’utilise est obligé de trouver une autre solution, ou pire il perd un temps précieux. Autre exemple : si l’interface d’un traitement de texte est complètement revue, son utilisateur ne peut pas la modifier, et doit se former à nouveau pour être en mesure de la comprendre et de la prendre en main. Avec des logiciels ouverts, une possibilité de modification par la communauté existe : cela ne veut pas dire que chaque problème a sa solution, mais il y a une possibilité.

L’arrivée du livre numérique a obligé les éditeurs à modifier une partie de cette chaîne et son mode de fonctionnement : en détournant l’usage d’un logiciel de PAO, ou en faisant appel à un autre outil – un logiciel dédié à la production de livre numérique –, et en devant ouvrir au moins en partie le code source de ces livres. L’environnement a donc changé, et la chaîne de publication a connu une correction mineure : elle a été perfectionnée par l’ajout d’un élément, et le mode de production n’a été modifié qu’en partie. Une chaîne de publication qui abandonne le duo traitement de texte et logiciel de PAO, et qui se base sur des technologies et des méthodes de travail du web, est une évolution majeure, et ce pour plusieurs raisons : il ne s’agit plus de simples perfectionnements fonctionnels ou correctifs – par exemple pour produire un livre numérique au format EPUB –, mais une modification de l’ensemble des éléments pour parvenir à produire un livre en plusieurs formats, dont le format EPUB.